Le paradoxe de Moravec : pourquoi l'IA excelle aux échecs mais trébuche dans les escaliers

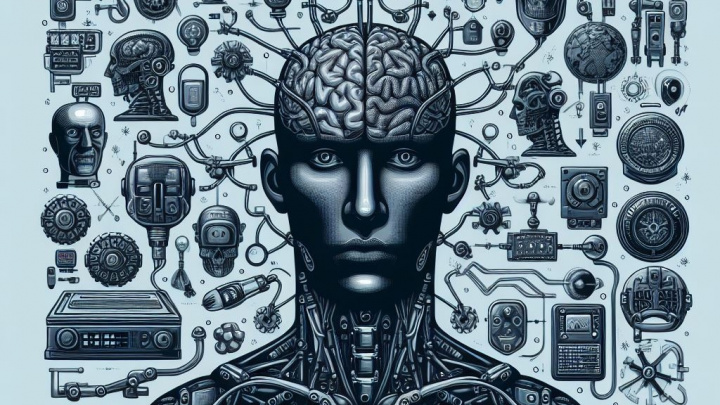

Imaginez une machine capable de vaincre le plus grand maître d'échecs au monde, de composer des symphonies ou de prouver des théorèmes mathématiques complexes. Imaginez maintenant cette même machine peinant à simplement traverser une pièce sans heurter les meubles, ou incapable de verser une tasse de café de manière fiable. Ce contraste saisissant est au cœur du paradoxe de Moravec, une observation fondamentale en intelligence artificielle et en robotique, formulée pour la première fois par Hans Moravec et d'autres dans les années 1980. Il révèle une inversion surprenante de la difficulté entre les humains et les machines : ce que nous trouvons difficile, ils le trouvent souvent facile, et ce qui nous vient naturellement peut être extrêmement difficile pour eux. Pourquoi en est-il ainsi, et qu'est-ce que cela nous dit sur la nature de l'intelligence elle-même ?

Le cœur du problème : Facile vs. Difficile, inversé

Essentiellement, le paradoxe de Moravec met en évidence une dichotomie frappante. Le raisonnement de haut niveau – des tâches comme la planification stratégique (échecs), la manipulation symbolique (mathématiques) ou la logique abstraite – qui exigent des efforts conscients importants et des années de formation pour les humains, peuvent souvent être reproduits par des ordinateurs avec des ressources de calcul relativement modestes. Les algorithmes peuvent suivre des règles, explorer de vastes espaces de possibilités et optimiser les résultats dans des domaines bien définis avec une efficacité remarquable.

Inversement, les compétences sensorimotrices de bas niveau qu'un enfant en bas âge maîtrise sans effort – reconnaître un visage dans une foule, se déplacer sur un terrain accidenté, ramasser un objet inconnu, maintenir son équilibre – s'avèrent extraordinairement difficiles et coûteuses en calcul à reproduire chez les machines. Ce sont des tâches que nous effectuons intuitivement, en grande partie inconsciemment, en nous appuyant sur une base de compétences perfectionnées au cours de millions d'années d'évolution.

Percer le « Pourquoi » : L'évolution et le cauchemar de la réalité

L'explication la plus courante découle des échelles de temps évolutives. Nos compétences sensorimotrices représentent le socle ancien de l'intelligence animale. La perception, la mobilité et l'interaction avec le monde physique ont été constamment affinées pendant des centaines de millions d'années. Ces capacités sont profondément ancrées dans notre architecture neuronale, optimisées à un degré incroyable pour naviguer dans les complexités du monde réel.

Le raisonnement abstrait, le langage et les mathématiques, bien que caractéristiques de l'intelligence humaine, sont des développements évolutifs beaucoup plus récents – à peine des dizaines ou des centaines de milliers d'années. Ils n'ont pas bénéficié des mêmes éons d'optimisation et sont moins profondément ancrés, ce qui rend leur logique sous-jacente potentiellement plus facile (bien que non triviale) à rétro-ingénier et à implémenter algorithmiquement.

Mais il y a plus que l'âge évolutif. La reproduction des compétences sensorimotrices est un cauchemar computationnel parce que le monde physique est intrinsèquement désordonné, imprévisible et nécessite le traitement d'un torrent de données sensorielles bruyantes et en temps réel. Prenons l'exemple de la marche : elle implique un balayage visuel constant, le traitement du retour tactile des pieds, le maintien de l'équilibre dynamique en intégrant les signaux de l'oreille interne, la prédiction du frottement de la surface et la réalisation de micro-ajustements – le tout simultanément et de manière adaptative. Cela nécessite :

- Traitement parallèle massif : Gestion simultanée de diverses entrées sensorielles.

- Navigation dans l'ambiguïté et l'incertitude : Gestion des informations incomplètes, du bruit des capteurs et des événements imprévisibles.

- Intuition physique implicite : Une vaste compréhension tacite de la physique (« bon sens ») – comment les objets se comportent, les effets de la gravité, les propriétés des matériaux.

- Cognition incarnée : Notre intelligence n'est pas seulement dans notre cerveau ; elle est profondément liée à notre corps physique et à ses interactions avec l'environnement. L'IA traditionnelle manque souvent de cet ancrage.

Le fantôme de Moravec dans la machine IA moderne

Le paradoxe reste d'une pertinence frappante, même au milieu des avancées actuelles de l'IA :

- Le double tranchant de l'apprentissage profond : Bien que l'apprentissage profond ait révolutionné les tâches de perception comme la reconnaissance d'images et de la parole (surmontant certains obstacles perceptuels antérieurs), la construction de robots dotés d'une dextérité, d'une adaptabilité et de compétences d'interaction physique robustes semblables à celles de l'homme reste un défi de pointe. Les robots ont encore du mal à manipuler des objets inconnus ou à s'adapter à des situations physiques inattendues.

- L'ascension de l'apprentissage par renforcement : Des techniques comme l'apprentissage par renforcement permettent aux IA d'apprendre des comportements complexes par essais et erreurs, ce qui est prometteur en robotique. Cependant, elles nécessitent souvent de grandes quantités de données d'entraînement (réelles ou simulées) et peuvent avoir du mal à transférer efficacement l'apprentissage de la simulation au monde réel imprévisible (le « fossé sim-réel »).

- L'éloquence des grands modèles linguistiques (LLM) : Des modèles comme ChatGPT présentent des capacités étonnantes en matière de langage, de logique et de génération de code – des exemples classiques de raisonnement de haut niveau. Pourtant, ils ne possèdent aucune compréhension réelle du monde physique dérivée de l'expérience sensorielle. Ils peuvent décrire la descente d'un escalier sans faute, mais n'ont aucune compréhension incarnée de l'équilibre, de la gravité ou de la sensation d'une marche – une manifestation moderne et frappante du paradoxe.

Ondes plus larges : Automatisation, IAG et repenser l'intelligence

Le paradoxe de Moravec a des implications importantes au-delà du laboratoire :

- L'avenir du travail : Il suggère que les emplois exigeant un raisonnement abstrait de haut niveau (par exemple, l'analyse de données, la programmation, la modélisation financière) pourraient, de manière contre-intuitive, être plus susceptibles d'être automatisés à court terme que les emplois exigeant une dextérité physique, une conscience de la situation et une interaction avec le monde physique imprévisible (par exemple, la plomberie, les soins aux personnes âgées, la construction, les métiers artisanaux).

- La quête de l'intelligence artificielle générale (IAG) : Le paradoxe implique fortement que la réalisation d'une IAG semblable à celle de l'homme ne consistera pas seulement à augmenter la puissance de calcul pour la pensée abstraite. Elle nécessitera probablement de percer le code de l'intelligence sensorimotrice et de l'intégrer de manière transparente au raisonnement – en créant une IA incarnée qui apprend par l'expérience physique.

- Qu'est-ce qui est « difficile » ? Il nous oblige à remettre en question nos hypothèses sur l'intelligence. La pensée abstraite est-elle vraiment le summum, ou la maîtrise sans effort du monde physique est-elle une forme d'intelligence plus profonde et plus fondamentale que nous tenons souvent pour acquise ?

Conclusion : Une idée durable

Le paradoxe de Moravec est plus qu'une simple note de bas de page historique ; c'est une idée durable sur les différentes architectures de l'intelligence biologique et artificielle. Il met en évidence l'immense complexité cachée dans nos capacités physiques apparemment simples et souligne les défis liés à la création de machines intelligentes véritablement polyvalentes. Alors que l'IA continue de réaliser des prouesses surhumaines dans des domaines spécifiques, souvent abstraits, le miracle quotidien de la compétence physique humaine (et animale) nous rappelle constamment le vaste paysage qui reste à conquérir. La compréhension de ce paradoxe est cruciale non seulement pour apprécier nos propres capacités, mais aussi pour guider la trajectoire future de la recherche en intelligence artificielle vers des systèmes qui peuvent réellement percevoir, agir et apprendre dans la richesse du monde réel.