Blackwell平台使企业能够构建和运行前所未有的大型AI模型,其规模可能扩展到 数万亿参数。这种能力对于在数据处理、工程模拟、电子设计自动化 (EDA)、计算机辅助药物设计、量子计算以及快速发展的生成式AI等复杂领域取得突破至关重要。

Blackwell架构引入了多项关键创新,旨在应对现代AI对计算的巨大需求:

- 它融合了 六项变革性技术,专为提升AI、数据分析和高性能计算 (HPC) 的加速计算能力而设计。这些技术包括:专用的 RAS(可靠性、可用性、可维护性)引擎,用于提高系统正常运行时间;以及提供保密计算能力的 安全AI 功能。

- 采用 全新Tensor Cores 和增强的 TensorRT-LLM 编译器。两者结合使用,可以将大型语言模型 (LLM) 推理的运营成本和能耗降低高达 25 倍(与上一代 Hopper 相比)。

- 该平台已获得 主要行业参与者的强力支持,包括亚马逊云科技 (AWS)、戴尔科技、谷歌、Meta、微软、OpenAI、Oracle、特斯拉和 xAI,预示着其将在云和企业领域得到广泛而快速的应用。

关键技术创新:

- 第二代Transformer引擎 利用全新的微张量缩放支持,并将先进的动态范围管理算法与新颖的 4 位浮点 (FP4) 精度相集成。这使得计算性能和模型规模能力能够翻倍,同时保持高精度,这对于训练和运行大规模基础模型至关重要。

- 包含英伟达 第五代 NVLink 高速互连技术。它为每个GPU提供突破性的 1.8 TB/s 双向吞吐量。这实现了在大型服务器机架中通过全新 NVLink Switch 7.2T 系统连接的最多 576 个 GPU 之间无缝、高带宽的通信,这对于训练超过万亿参数的模型至关重要。

- 专用的 解压缩引擎 通过支持最新格式来加速数据库查询和数据分析,从而显著加快数据处理任务的速度,而数据处理任务通常是 AI 工作流程中的瓶颈。

Blackwell平台的应用:

- DGX SuperPOD™ 由 NVIDIA GB200 Grace Blackwell 超级芯片驱动,代表着AI超级计算基础设施的又一次飞跃。它专为处理万亿参数生成式AI模型而设计,在液冷机架式设计中提供强大的性能、可扩展性(高达数万个GPU)和高能效。

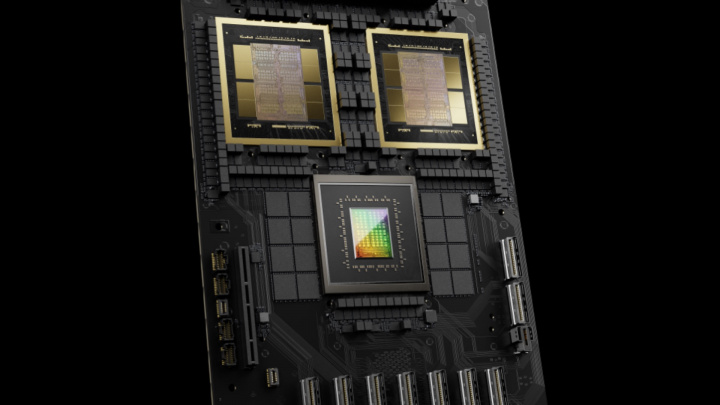

- GB200 Grace Blackwell 超级芯片 本身通过超高速 900GB/s 芯片到芯片链路将两个 Blackwell B200 GPU 连接到一个 NVIDIA Grace CPU。这种紧密耦合的配置承诺,与已经非常强大的 H100 GPU 相比,LLM推理工作负载的性能提升高达 30 倍,同时能效也得到显著提升。

NVIDIA Blackwell 平台标志着计算技术的重大进步,为最苛刻的AI应用提供了前所未有的效率、性能和可扩展性。它获得了领先科技公司的认可,其基于先进工艺技术的创新chiplet架构,以及其在彻底改变各行各业的潜力,都突显了其在计算和人工智能持续发展中的重要性。