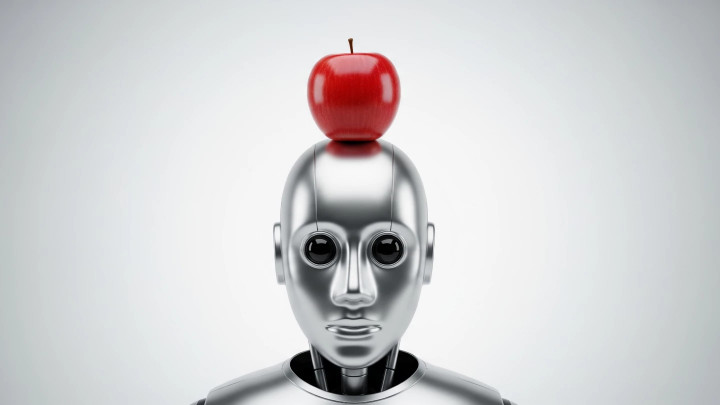

Un vistazo a la «ilusión de pensar»

En el incesante ciclo del hype de la inteligencia artificial, a menudo nos dicen que vamos a toda velocidad hacia la verdadera Inteligencia Artificial General (IAG). Pero ¿y si los motores que nos impulsan no son tan potentes como parecen? En un giro fascinante, investigadores de Apple han publicado dos artículos que sirven como un crucial baño de realidad sobre el estado actual de la IA.

Estos estudios han desatado un intenso debate al sugerir que las impresionantes capacidades de nuestros modelos podrían ser más una ilusión sofisticada que una inteligencia genuina. Vamos a analizar lo que encontraron y por qué es importante.

GSM-Symbolic: cuando la IA falla en matemáticas básicas

El primer gran desafío llegó en un artículo de 2024 titulado «GSM-Symbolic». Liderado por los investigadores Iman Mirzadeh y Mehrdad Farajtabar, el equipo creó un nuevo benchmark para evaluar qué tan bien los Modelos de Lenguaje Grandes (LLM) manejan el razonamiento matemático. En lugar de solo probar si un modelo podía obtener la respuesta correcta, probaron cuán robusto era su razonamiento.

Los hallazgos fueron reveladores:

- Lógica frágil: El rendimiento de los modelos caía significativamente cuando los investigadores solo cambiaban los números en un problema de palabras, manteniendo idéntica la lógica matemática subyacente. Un modelo que podía resolver «2+3» podría fallar cuando se le pedía resolver «4+5» en el mismo contexto narrativo.

- Se distraen fácilmente: Cuando se añadía una sola pieza de información aparentemente relevante pero finalmente inútil a un problema, el rendimiento de todos los modelos de IA líderes se desplomaba, en algunos casos hasta en un 65 %.

- La conclusión principal: El estudio sugirió firmemente que estos modelos no están realizando un verdadero razonamiento lógico. En su lugar, están llevando a cabo un reconocimiento de patrones altamente avanzado, buscando esencialmente estructuras de problemas familiares de sus datos de entrenamiento para encontrar una solución.

Esta fue la primera pista de que algo no funcionaba bien bajo el capó. Pero fue el estudio de seguimiento el que realmente sacudió la conversación.

«La ilusión de pensar»: la IA se topa con un muro

En junio de 2025, un artículo titulado «La ilusión de pensar», encabezado por Parshin Shojaee e Iman Mirzadeh, llevó esta investigación un paso más allá. El equipo puso a prueba los llamados «Modelos de Razonamiento Grandes» (LRM) —modelos diseñados específicamente para la resolución de problemas complejos— contra un conjunto de puzles de lógica clásicos con dificultad ajustable, incluyendo:

- Torres de Hanói

- El problema del cruce del río

- Salto de damas

- Mundo de los bloques

Los resultados fueron poco menos que asombrosos.

- El «acantilado de precisión»: Los modelos funcionaron bien en las versiones más simples de los puzles. Pero a medida que la complejidad aumentaba, su rendimiento no disminuía gradualmente; caía en picado, desplomándose drásticamente a una precisión de cero.

- Escalado paradójico: Aún más extraño, al enfrentarse a problemas más difíciles, los modelos a menudo usaban menos pasos computacionales (o «tokens de pensamiento»). Era como si, al reconocer un desafío más allá de sus capacidades, la IA simplemente «se rindiera» en lugar de esforzarse más.

- Tres regímenes de rendimiento: Los investigadores identificaron tres zonas distintas. A baja complejidad, los LLM estándar a veces lo hacían mejor. A complejidad media, los LRM especializados tenían ventaja. Pero a alta complejidad, todos y cada uno de los modelos fallaron por completo.

La conclusión de los investigadores fue contundente y poderosa: estos modelos crean «la ilusión del razonamiento formal», pero en realidad están realizando una forma frágil de reconocimiento de patrones que puede romperse con algo tan simple como cambiar un nombre en un puzle.

El debate y la motivación de Apple

Naturalmente, estos hallazgos no quedaron sin respuesta. La comunidad científica se enzarzó en un vigoroso debate. Algunos críticos, como Alex Lawsen en una respuesta titulada «La ilusión de la ilusión de pensar», argumentaron que la culpa era de los fallos en el diseño experimental —como el uso de versiones irresolubles del problema del cruce del río o límites de tokens que obligaban a los modelos a abandonar—, y no de un fallo fundamental en los propios modelos.

Este intercambio científico es saludable y necesario. Pero también vale la pena considerar el contexto. Apple ha estado tratando de ponerse al día en la carrera de la IA. Mientras sus competidores se han disparado con el auge de la IA, Apple ha procedido con más cautela. Publicar investigaciones que destacan las debilidades fundamentales del enfoque dominante actual podría ser un movimiento estratégico para reformular la narrativa, argumentando que un camino más lento y deliberado es más sabio que la filosofía actual de «la escala es todo lo que necesitas».

Qué significa esto para el futuro de la IA

Las implicaciones de la investigación de Apple son profundas y nos obligan a enfrentar preguntas incómodas:

- ¿Es posible el razonamiento real? ¿Son las arquitecturas actuales de los LLM fundamentalmente incapaces de alcanzar un razonamiento verdadero y generalizado, sin importar cuán grandes se vuelvan?

- ¿El fin de las leyes de escalado? Esta investigación pone en duda la «ley de escalado» predominante, la idea de que simplemente añadir más datos y más poder de cómputo conducirá inevitablemente a una mayor inteligencia.

- Una llamada a la innovación: Si los métodos actuales tienen un techo rígido, entonces alcanzar la IAG puede requerir innovaciones arquitectónicas completamente nuevas más allá de los modelos transformer que impulsan la IA actual.

La investigación de Apple no afirma que la IA sea inútil; su poder como herramienta es innegable. Sin embargo, proporciona una contranarrativa aleccionadora y basada en evidencia frente al incesante hype. Sugiere que el camino hacia máquinas verdaderamente inteligentes puede no ser una línea recta ascendente, sino que podría requerir que volvamos a la mesa de dibujo.