El campeón inesperado

En el mundo de la ciencia, a veces las ideas más profundas provienen de los experimentos más sencillos. A principios de la década de 1980, en los albores de la era de la computación personal, un politólogo llamado Robert Axelrod organizó una arena digital para enfrentar programas informáticos —cada uno con su propia "personalidad"— en un clásico juego de estrategia. Los resultados no solo fueron sorprendentes, sino revolucionarios, y ofrecieron una nueva y poderosa lente a través de la cual ver la evolución de la propia cooperación.

Preparando el escenario: el dilema de la confianza

El experimento se basó en uno de los rompecabezas más famosos de la teoría de juegos: el dilema del prisionero.

Probablemente esté familiarizado con el planteamiento clásico: dos cómplices de un delito son arrestados y recluidos en celdas separadas, sin poder comunicarse. El fiscal le ofrece a cada uno un trato, de forma individual.

- Si traicionas a tu compañero (desertar) y él guarda silencio (cooperar), tú quedas libre y él recibe una larga condena (p. ej., 10 años).

- Si ambos guardan silencio (cooperar), ambos reciben una condena corta (p. ej., 1 año).

- Si ambos se traicionan mutuamente (desertar), ambos reciben una condena media (p. ej., 5 años).

Desde una perspectiva puramente individualista y racional, desertar es siempre la mejor jugada. Si tu compañero coopera, obtienes el mejor resultado (la libertad). Si tu compañero deserta, evitas el peor resultado (ser el incauto). La paradoja es que cuando ambos jugadores siguen esta lógica "racional", ambos terminan en una situación peor que si hubieran confiado el uno en el otro.

Axelrod estaba interesado en lo que sucede cuando no se trata de un encuentro único. Se centró en el dilema del prisionero iterado (DPI), donde los mismos dos jugadores se enfrentan una y otra vez. De repente, la reputación y la memoria importan. La "sombra del futuro" lo cambia todo. ¿Tiene alguna oportunidad la cooperación?

El gran torneo de algoritmos

Para encontrar la respuesta, Axelrod invitó a académicos de diversos campos (economía, psicología, matemáticas e informática) a presentar un programa que jugara al dilema del prisionero iterado. Sin embargo, antes de presentar a los contendientes digitales, es esencial comprender las reglas del juego que determinarían su éxito o fracaso.

Puntos en lugar de prisión: la estructura del torneo

Para hacer competir a las estrategias en un torneo informático, Axelrod tuvo que traducir el dilema del prisionero al lenguaje de los bits y los bytes. En lugar de la amenaza abstracta de años de prisión, introdujo un sistema concreto y medible: los puntos. La lógica del planteamiento se mantuvo, pero la perspectiva se invirtió. El objetivo ya no era minimizar el castigo, sino maximizar la recompensa.

En cada ronda, los dos jugadores (programas) podían ganar puntos. Su decisión —cooperar o desertar— determinaba la recompensa. La matriz de puntuación que sirvió de base para el torneo era la siguiente:

- Cooperación mutua: si ambos programas eligen cooperar, ambos reciben una recompensa justa y agradable. Cada uno obtiene 3 puntos. Esta es la recompensa por la confianza y la colaboración.

- Tú desertas, ellos cooperan: si eliges desertar mientras tu oponente coopera ingenuamente, te llevas el premio mayor y él se queda sin nada. Tú obtienes 5 puntos (la recompensa de la tentación) y tu oponente obtiene 0 (la recompensa del incauto).

- Deserción mutua: si ambos eligen el camino de la desconfianza y desertan, cada uno recibe un premio de consolación mínimo, pero les va mucho peor que si hubieran cooperado. Cada uno obtiene solo 1 punto. Este es el castigo por la desconfianza mutua.

Este sistema de puntuación preserva brillantemente la tensión del dilema original:

- La tentación siempre está ahí: sin importar lo que haga tu oponente en una sola ronda, siempre es mejor para ti desertar. Si coopera, obtienes 5 puntos en lugar de 3. Si deserta, obtienes 1 punto en lugar de 0.

- La paradoja permanece: si ambos jugadores siguen esta lógica "racional" a corto plazo, cada uno obtiene 1 punto por ronda. Por el contrario, si hubieran confiado el uno en el otro, podrían haber ganado 3 puntos cada uno. La ganancia total para la pareja por la deserción mutua (1+1=2) es mucho menor que por la cooperación mutua (3+3=6).

Y aquí es donde se pone interesante. Dado que el torneo duraba 200 rondas, ganar una sola partida (embolsándose los 5 puntos) podía ser una victoria pírrica. Si un programa se forjaba una reputación de desertor despiadado, otros programas (capaces de recordar jugadas pasadas) simplemente se negarían a cooperar con él. Este programa se condenaría a sí mismo a deserciones mutuas a largo plazo, ganando solo 1 punto por ronda.

El verdadero desafío no era cómo vencer a un oponente en una ronda determinada, sino cómo fomentar un entorno en el que la cooperación mutua (el resultado de 3 puntos) pudiera florecer. La clave del éxito no era noquear a tu oponente, sino construir una asociación fructífera y a largo plazo con él. Con esta configuración, Axelrod hizo que la confianza, la reputación y el peso de las consecuencias futuras fueran fundamentales para la competencia.

Axelrod invitó a presentar propuestas a una amplia gama de expertos. Cada programa era una estrategia, un conjunto de reglas para decidir si cooperar o desertar en una ronda determinada.

Las propuestas iban desde las brillantemente complejas hasta las endiabladamente sencillas. Algunas eran implacablemente maliciosas, desertando siempre. Otras eran puramente altruistas, cooperando siempre. Muchas eran muy sofisticadas y utilizaban análisis estadísticos para predecir el siguiente movimiento de su oponente. Estas "personalidades" digitales se inscribieron en un torneo de todos contra todos. Cada programa jugó contra todos los demás programas (además de un clon de sí mismo y un programa que hacía movimientos aleatorios) durante 200 rondas. El objetivo no era "ganar" partidas individuales, sino lograr la puntuación total más alta en todo el torneo.

El escenario estaba listo para un choque de titanes digitales. La expectativa era que prevaleciera una estrategia compleja y astuta.

Lo que sucedió a continuación fue extraordinario.

El ganador: una clase magistral de simplicidad

Cuando el polvo digital se asentó, el vencedor fue una de las estrategias más simples presentadas. Su nombre era Toma y daca (Tit for Tat), y fue escrita por Anatol Rapoport, un psicólogo matemático.

La lógica de Toma y daca era casi ridículamente simple:

- En el primer movimiento, coopera.

- En cada movimiento posterior, haz lo que tu oponente hizo en su movimiento anterior.

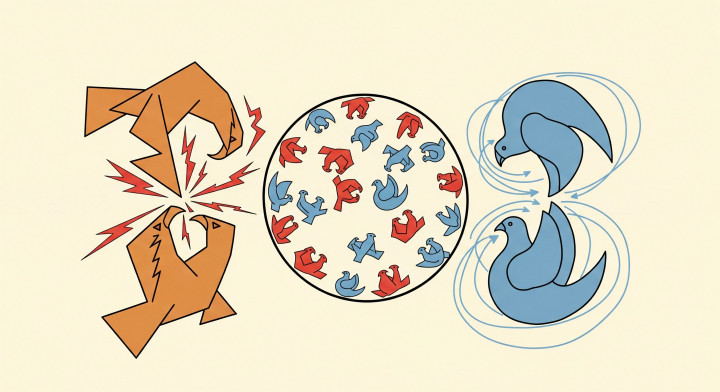

Eso es todo. Si el oponente cooperaba, Toma y daca cooperaba. Si desertaba, Toma y daca desertaba inmediatamente en respuesta. Era un simple eco, un espejo digital. No guardaba rencor más allá del último movimiento inmediato y nunca intentó ser más listo que su oponente.

¿Cómo pudo un algoritmo tan básico triunfar sobre programas diseñados con complejos modelos predictivos y lógica maquiavélica? El análisis de los resultados de Axelrod reveló los ingredientes clave para una cooperación exitosa, que Toma y daca encarnaba a la perfección. Identificó cuatro propiedades que compartían las estrategias con mayor puntuación:

- Era amable: un programa "amable" es aquel que nunca es el primero en desertar. Al comenzar con la cooperación, Toma y daca señalaba inmediatamente su voluntad de trabajar juntos, abriendo la puerta a resultados mutuamente beneficiosos y evitando conflictos innecesarios.

- Era reactiva (o provocable): Toma y daca no era fácil de doblegar. Si un oponente desertaba, tomaba represalias inmediatamente en el siguiente movimiento. Este castigo rápido dejaba claro que la explotación no sería tolerada, disuadiendo a las estrategias agresivas de intentar aprovecharse de ella.

- Era indulgente: este es posiblemente su rasgo más importante. Después de tomar represalias por una deserción, si el oponente volvía a cooperar, Toma y daca "perdonaba" inmediatamente y cooperaba en el siguiente turno. No guardaba rencor. Esta capacidad para romper ciclos de recriminación mutua fue vital para restablecer la confianza y volver al ritmo de alta puntuación de la cooperación.

- Era clara: su estrategia era simple y transparente. Los oponentes aprendían rápidamente sus reglas. Podían entender que la cooperación sería recompensada y la deserción castigada. Esta claridad y previsibilidad la convertían en un socio fiable para la cooperación.

El elenco de personajes: un vistazo a los jugadores clave

Para hacer el torneo más concreto, conozcamos a algunas de las "personalidades" digitales que compitieron. Aunque se presentaron docenas de estrategias, a menudo se pueden agrupar en diferentes arquetipos. Aquí hay un vistazo a algunos de los contendientes más notables y su desempeño.

(Nota: la "Clasificación" es una generalización. En realidad, el rendimiento dependía de la mezcla específica de otras estrategias en el torneo, pero esto refleja los resultados generales).

| Clasificación | Nombre de la estrategia | Breve descripción | Rasgo(s) clave(s) |

| 1 | Toma y daca | Coopera en el primer movimiento, luego copia el movimiento anterior del oponente. | Amable, reactiva, indulgente, clara |

| Nivel superior | Probador | Deserta en el primer movimiento para "probar el terreno". Si el oponente responde, se disculpa y juega como Toma y daca. Si no, sigue desertando. | Exploradora, pero en última instancia cooperativa con los no-incautos. |

| Nivel superior | Friedman (Gatillo implacable) | Coopera hasta que el oponente deserta una sola vez, después de lo cual deserta para siempre. | Amable, implacablemente reactiva, no perdona |

| Nivel superior | Toma y daca por dos traiciones | Una versión más indulgente. Solo deserta después de que el oponente haya desertado dos veces seguidas. | Muy amable, indulgente, resiste los efectos de eco |

| Nivel medio | Joss | Una versión "astuta" de Toma y daca. Mayormente imita al oponente, pero tiene un 10 % de probabilidad de desertar en lugar de cooperar. | Mayormente amable, reactiva, pero "traicionera" |

| Nivel medio | Downing | Comienza tratando de modelar a su oponente. Si el oponente parece receptivo y tiene "conciencia", coopera. Si parece aleatorio o no receptivo, deserta para protegerse. | Adaptable, calculadora, no es "amable" por naturaleza |

| Nivel inferior | Desertar siempre (ALL D) | Siempre elige desertar, sin importar nada. | Maliciosa, agresiva |

| Nivel inferior | Aleatorio | Coopera o deserta con una probabilidad del 50/50. | Impredecible, poco fiable |

| Nivel más bajo | Cooperar siempre (ALL C) | Siempre elige cooperar, sin importar cuántas veces sea traicionado. | Amable, pero ingenua y explotable |

| Nivel más bajo | Nydegger | Una estrategia más complicada basada en reglas que intentaba ser una Toma y daca más indulgente, pero su lógica era defectuosa y explotable, lo que llevó a un bajo rendimiento. | Bienintencionada, pero confusa y explotable |

Esta tabla muestra claramente que las estrategias más exitosas eran "amables" (nunca eran las primeras en desertar), pero no eran fáciles de doblegar. Las estrategias puramente agresivas (ALL D) y puramente ingenuas (ALL C) tuvieron un rendimiento muy bajo, ya que fueron explotadas o quedaron atrapadas en patrones mutuamente destructivos.

La segunda ronda y el legado duradero

Pensando que los resultados podrían haber sido una casualidad, Axelrod organizó un segundo torneo, aún más grande. Esta vez, los participantes conocían los resultados de la primera ronda. Sabían del éxito de Toma y daca y podían diseñar estrategias específicamente para vencerla. Llegaron sesenta y dos propuestas de todo el mundo.

Y Toma y daca volvió a ganar.

Su robustez quedó demostrada. Los principios simples de ser inicialmente amable, rápido pero proporcionado en la represalia, inmediatamente indulgente y claro no eran solo una fórmula ganadora; parecían ser una receta fundamental para la evolución de la cooperación.

Teoría contra una realidad con ruido

Antes de aclamar a Toma y daca como la cura milagrosa para todos los conflictos de la vida, es crucial recordar que el torneo de Axelrod tuvo lugar en un "laboratorio" digital limpio. Los programas ejecutaban sus instrucciones sin fallos, no había malentendidos y cada movimiento era claramente una cooperación o una deserción.

Si bien los principios descubiertos son invaluables, la vida real rara vez es tan estéril. Está llena de mala comunicación, accidentes e intenciones malinterpretadas. La teoría de juegos describe esta imprevisibilidad como "ruido", y su presencia puede cambiar fundamentalmente la efectividad de una estrategia.

En un entorno con ruido, incluso Toma y daca se vuelve vulnerable. Imagine a dos jugadores de Toma y daca cooperando felizmente. Un solo malentendido hace que el movimiento cooperativo de un jugador sea percibido como una deserción. Siguiendo sus reglas, el segundo jugador toma represalias inmediatamente. El primer jugador, sin ser consciente del error inicial, ve esto como una deserción no provocada y toma represalias a su vez. Los dos pueden quedar atrapados en una "espiral de la muerte" de represalias mutuas, una disputa de sangre digital, todo por un error aleatorio.

Esta es precisamente la razón por la que trabajos y torneos posteriores exploraron variaciones más robustas, como Toma y daca por dos traiciones (que solo deserta después de dos deserciones consecutivas), Toma y daca generoso (que ocasionalmente perdona una deserción) y Gana-Quédate, Pierde-Cambia (Pavlov), todas las cuales pueden superar a la Toma y daca estándar bajo diversas tasas de error y dinámicas poblacionales. Reconocer este matiz ayuda a explicar por qué la dinámica de la cooperación a veces difiere entre el laboratorio y el mundo real.

Formalmente, la sostenibilidad de la cooperación en los dilemas del prisionero repetidos depende de dos componentes: el orden de las recompensas y el valor de la interacción futura. Las recompensas deben cumplir la condición T > R > P > S (Tentación > Recompensa > Castigo > Incauto), y los jugadores deben valorar suficientemente las recompensas futuras (una alta probabilidad de continuación o una baja tasa de descuento). Cuando estas condiciones se cumplen y las interacciones se repiten con una certeza razonable, las estrategias recíprocas pueden volverse auto-reforzantes, un puente entre los torneos empíricos de Axelrod y los hallazgos teóricos de la teoría de juegos repetidos.

Más allá de la simulación: la lógica de la cooperación en el mundo real

La pregunta surge naturalmente: ¿son las lecciones de la arena digital de Axelrod meras curiosidades teóricas, o revelan patrones reales en el mundo humano y natural? ¿Forman realmente los principios básicos de Toma y daca —amabilidad, represalia y perdón— los bloques de construcción universales de la cooperación?

La respuesta es fascinante. Resulta que esta lógica aparece una y otra vez en los lugares más inesperados, demostrando que la cooperación tiene profundas raíces evolutivas y sociales. A continuación se presentan algunos casos en los que los principios de Toma y daca surgieron espontáneamente, sin ningún diseño de arriba hacia abajo.

El ejemplo más sorprendente: las trincheras de la Primera Guerra Mundial

Quizás el paralelo más conmovedor del mundo real con los hallazgos de Axelrod proviene de un lugar donde menos esperaríamos cooperación: las trincheras de la Primera Guerra Mundial. Durante largos períodos de estancamiento en el Frente Occidental, surgió un sistema espontáneo e informal de tregua entre las tropas británicas y alemanas opuestas. Este fenómeno se conoció como el sistema de "Vivir y dejar vivir".

Funcionaba exactamente como un juego orgánico de Toma y daca:

- Sé amable (no dispares primero): una unidad señalaba sus intenciones pacíficas con rutinas predecibles y no letales. Por ejemplo, podían bombardear la misma parte vacía de la trinchera a la misma hora cada día. Este era un movimiento "cooperativo".

- Toma represalias: si un bando lanzaba de repente una incursión mortal y no provocada (una "deserción"), el otro bando respondía inmediatamente con un feroz contraataque para demostrar que la agresión no sería tolerada.

- Sé indulgente: de manera crucial, después de la represalia, el bando atacado a menudo volvía a su rutina "cooperativa" anterior, señalando su voluntad de restaurar la tregua. No guardaban rencor para siempre.

Este sistema tácito de cooperación surgió sin órdenes del alto mando (de hecho, los generales intentaron activamente erradicarlo). Surgió del interés propio de los soldados de ambos bandos, que reconocieron que estaban en un juego repetido. Sabían que se enfrentarían a los mismos oponentes mañana, y al día siguiente. La "sombra del futuro" se cernía sobre ellos, y se dieron cuenta de que la contención mutua era mucho mejor para su supervivencia que la agresión constante y desenfrenada.

Este poderoso ejemplo histórico muestra que los principios descubiertos en el torneo informático de Axelrod no son solo teoría abstracta. Son una parte fundamental de la supervivencia humana y la estrategia cooperativa, incluso en los entornos más hostiles imaginables. La lógica de Toma y daca no se limita al conflicto humano. Se puede observar en otros dominios:

- La reciprocidad de los murciélagos vampiro: en biología, un ejemplo clásico de altruismo recíproco es el comportamiento de los murciélagos vampiro. Estos animales se alimentan de sangre, pero una noche de caza puede no tener éxito. Un murciélago que regresa al refugio hambriento a menudo es alimentado con sangre regurgitada por un compañero de refugio bien alimentado. Los estudios han demostrado que los murciélagos son más propensos a compartir comida con un murciélago que los ha ayudado previamente. Esta es una clara estrategia de Toma y daca: coopera (comparte sangre) con aquellos que han cooperado contigo, y no ayudes a aquellos que se han negado a ayudar en el pasado (represalia).

- Relaciones comerciales y fijación de precios: en economía, los acuerdos de precios (a menudo tácitos) entre empresas pueden seguir este patrón. Dos competidores pueden evitar una guerra de precios mutuamente destructiva (cooperación mutua). Pero si una empresa recorta repentinamente los precios para ganar cuota de mercado (deserción), la otra hará lo mismo casi de inmediato (represalia), perjudicando en última instancia los beneficios de ambas empresas. La estabilidad solo se restaura cuando vuelven al nivel de precios previamente entendido (perdón).

Estos ejemplos resaltan cómo el experimento de Axelrod descubrió un mecanismo fundamental que permite que la confianza y la cooperación surjan incluso entre actores racionales y egoístas, siempre que su relación sea a largo plazo.

Conclusión

El trabajo de Axelrod, que culminó en su libro seminal de 1984, La evolución de la cooperación, ha tenido un profundo impacto mucho más allá de la teoría de juegos. Los biólogos lo han utilizado para modelar el altruismo recíproco en poblaciones animales. Los economistas lo han aplicado para comprender la confianza en las relaciones comerciales. Los politólogos han visto su reflejo en la diplomacia internacional y los tratados de control de armas durante la Guerra Fría.

Hoy en día, estos simples principios de reciprocidad inspiran trabajos más allá de las ciencias sociales: los diseñadores de sistemas multiagente, los protocolos descentralizados y los mecanismos de incentivos de blockchain, y los equipos de IA que interactúan, todos se enfrentan a las mismas disyuntivas entre explotación y cooperación. El diseño de reglas de reciprocidad robustas —aquellas que toleran el ruido y escalan a través de las poblaciones— sigue siendo fundamental para la ingeniería del comportamiento cooperativo tanto en sistemas humanos como artificiales.

El torneo nos enseñó una poderosa lección: la cooperación no requiere ni una autoridad central ni un altruismo desinteresado. Puede surgir espontáneamente entre individuos egoístas, siempre que sepan que volverán a encontrarse. En un mundo que a menudo parece complejo y cínico, el triunfo de Toma y daca es un recordatorio esperanzador y duradero de que la mejor estrategia suele ser ser amable, pero no ingenuo; indulgente, pero sin olvidar; y, sobre todo, claro y coherente en nuestras acciones.

Históricamente, estos torneos fueron organizados y analizados por Robert Axelrod, quien coordinó las propuestas y sintetizó los hallazgos en su influyente trabajo. La estrategia conocida como Toma y daca —a menudo atribuida a Anatol Rapoport como uno de sus primeros defensores— se hizo famosa por el análisis de Axelrod. Para la presentación canónica del experimento y sus implicaciones, véase el trabajo de Axelrod (Axelrod & Hamilton, 1981; Axelrod, 1984). Estudios teóricos y empíricos posteriores (p. ej., Nowak & Sigmund, 1993) han profundizado nuestra comprensión, mostrando cuándo y por qué otras reglas de reciprocidad (como Gana-Quédate, Pierde-Cambia o variantes más generosas) pueden superar a la simple Toma y daca bajo diferentes condiciones.