当谈到 AI 和 GPU 时,英伟达的名字几乎是同义词。这有很多原因,但最重要的原因是 CUDA 平台和 Tensor Cores。

CUDA(Compute Unified Device Architecture,计算统一设备架构) 是英伟达开发的并行计算平台和编程模型。它允许 GPU 用于通用计算(GPGPU),而不仅仅是图形处理。本质上,CUDA 充当软件和 GPU 硬件之间的“桥梁”,使开发人员更容易利用 GPU 的计算能力。对我而言,CUDA 最大的优势在于它提供了一个相对统一且文档完善的环境,大大简化了 AI 开发。这就是它成为行业标准的原因。

Tensor Cores(张量核心) 是英伟达 GPU 内的专用单元,专门用于加速深度学习中使用的矩阵运算。这些运算构成了深度学习网络的基础,Tensor Cores 显著提高了计算速度和效率。更新一代的 Tensor Cores 提供更高的性能和精度。

AI 中的数字格式:为何重要?

人工智能,尤其是深度学习,需要大量的计算。在这些计算过程中使用的数字格式(即数字在计算机中存储和处理的方式)直接影响:

- 速度: 较低精度格式(较少位数)可以实现更快的计算。

- 内存需求: 较少位数需要更少的内存,这对于加载和运行大型模型至关重要。

- 功耗: 处理较少位数通常消耗更少的能量。

- 精度: 较高精度格式(较多位数)产生更准确的结果,但这可能会以速度、内存和功耗为代价。

硬件对这些数字格式的支持对于 GPU(和其他 AI 加速器)至关重要,因为它决定了计算的根本效率。

英伟达架构在 AI 执行中的时间顺序

Tesla (2006)

首个支持 CUDA 的架构,开启了 GPGPU 革命,尽管当时还没有 Tensor Cores。

不建议用于 AI 执行, 也许只适合以非常低廉的价格购买来进行实验。没有专门的 AI 加速。CUDA 支持有限,驱动程序非常旧。

典型型号:GeForce 8、9、200、300 系列

Fermi (2010)

不建议用于 AI 执行。 CUDA 核心数量少,计算性能低。仅适用于非常简单的模型,即使如此也不一定值得。可能不值得投入时间和精力。

典型型号:GeForce 400、500 系列

Kepler (2012)

专注于提高效率,引入了动态并行。更好的 CUDA 支持,但仍然不足以满足现代 AI 的需求。 可能是低预算的入门选择,但会有所妥协。检查驱动程序支持非常重要!

典型专业型号:Tesla K10、K20、K20X、K40 (12 GB)、K80、Quadro K2000、K4000、K5000、K6000 等。消费级:GeForce 600、700 系列

Maxwell (2014)

主要目标是显著提高能效。改进了电源效率,提高了 CUDA 性能。可以用于分辨率较低的小型模型。

典型专业型号:Tesla M4、M40、M60、Quadro M2000、M4000、M5000、M6000 等。消费级:GeForce 750Ti、900 系列、GTX Titan X

Pascal (2016)

NVLink(更快的 GPU-GPU 通信)和 FP16(半精度浮点)支持的引入是迈向 AI 的重要一步。这标志着 AI 取得了更显著的进步。适用于运行中型模型。1080 Ti 在今天仍然是一款强大的显卡。GTX 1060 6GB 是入门级,而 1070、1080 和 1080 Ti 则更适合更严肃的任务。

典型专业型号:Tesla P4 (8GB)、P40 (24GB)、P100 (16GB)、Quadro P2000、P4000、P5000、P6000、GP100 等。消费级:GeForce 10 系列(GTX 1060、1070、1080、1080 Ti、Titan Xp)

Volta (2017)

Tensor Cores 首次出现在这里, 为深度学习性能带来了巨大的提升。从运行 LLM 的角度来看,这可以被认为是一个重要的里程碑。专业卡价格昂贵,但为较小模型提供了出色的 AI 性能。

Tesla V100 (16/32GB, HBM2)、Quadro GV100、Titan V

Turing (2018)

除了光线追踪 (RT) 核心外,还引入了 INT8(8 位整数)支持,旨在加速推理。非常出色。 具有 Tensor Cores 和光线追踪 (RT) 核心。适用于更严肃的 AI 项目(具有足够的 VRAM)。

典型专业型号:Tesla T4 (16GB, GDDR6)、T10、T40 (24GB, GDDR6)、Quadro RTX 4000、5000、6000、8000。消费级:GeForce RTX 20 系列(RTX 2060、2070、2080、2080 Ti)、Titan RTX

Ampere (2020)

第二代 RT 核心、第三代 Tensor Cores 以及 TF32 (TensorFloat-32) 格式的引入。适用于大多数 AI 任务。

典型专业型号:A100 (40/80GB, HBM2e)、A40 (48GB, GDDR6)、A30、A16、A10、RTX A4000、A4500、A5000、A5500、A6000 等。消费级:GeForce RTX 30 系列(RTX 3060、RTX 3070、RTX 3080、RTX 3090 (24GB, GDDR6x))

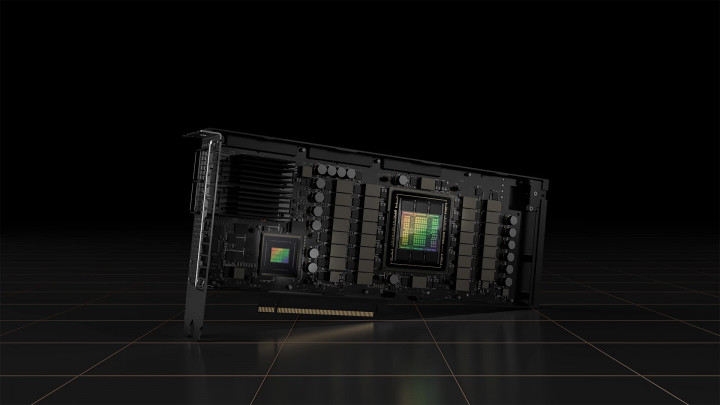

Hopper (2022)

第四代 Tensor Cores、Transformer Engine(专门为 LLM 优化)和 FP8 支持。专为数据中心设计。以极高的价格提供非凡的性能。

典型专业型号:H100 (80GB HBM3)、H200 (141GB, HBM3e)

Ada Lovelace (2022)

第四代 Tensor Cores、DLSS 3 和优化的能效。

典型专业型号:RTX 6000 Ada Generation (48GB, GDDR6 ECC)、L4、L40、L40S 等。消费级:GeForce RTX 40 系列(RTX 4060、RTX 4070、RTX 4080、RTX 4090 (24GB, GDDR6X))

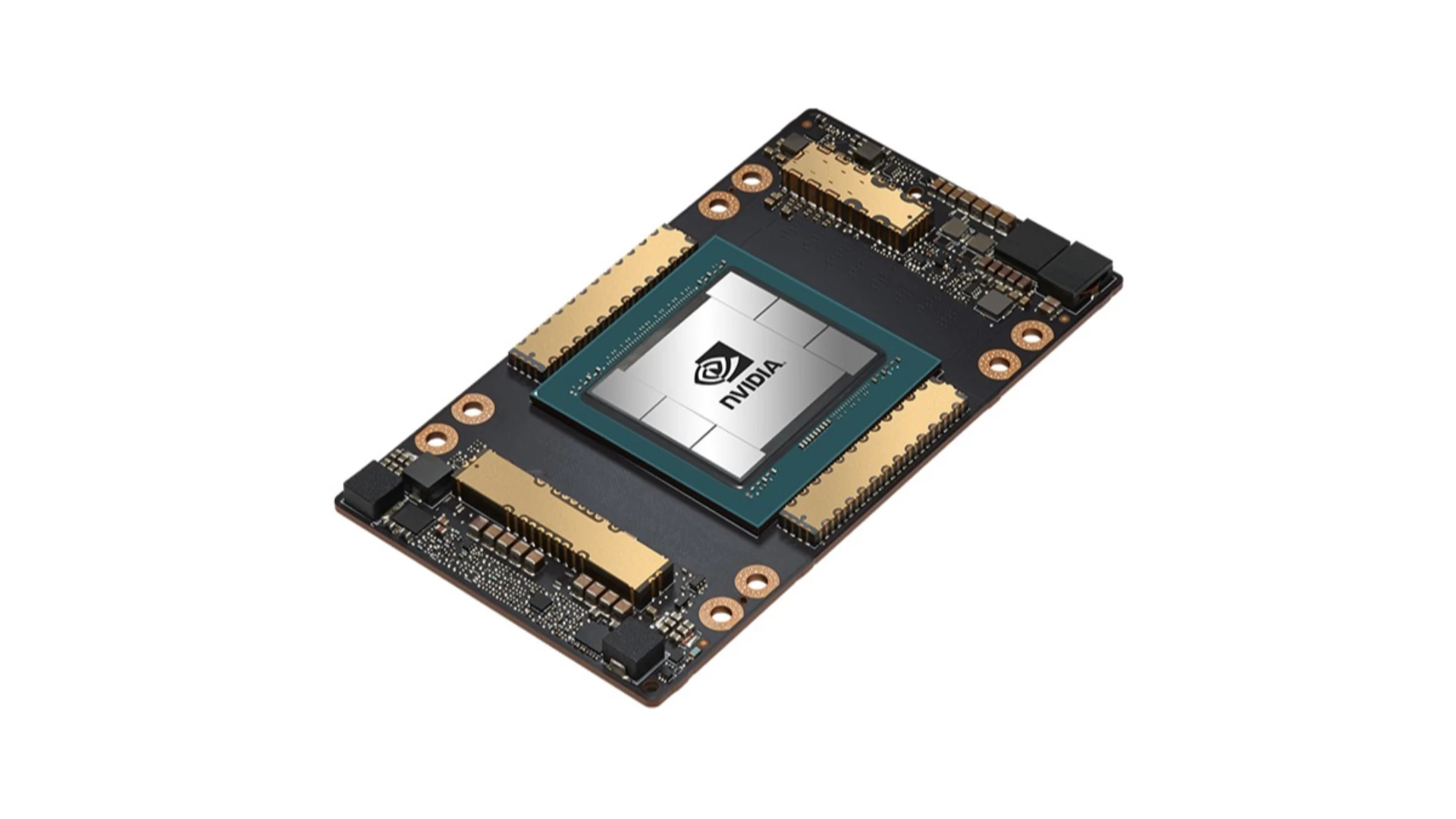

Blackwell (2024)

最新一代,承诺提供更高的性能、新的 Tensor Cores 和增强的 NVLink。硬件支持 FP4。

典型专业型号:B100、B200、GB200。 消费级:GeForce RTX 50 系列(预计:RTX 5060、RTX 5070、RTX 5080、RTX 5090 (可能 32GB GDDR7))

消费级与专业级 GPU

消费级显卡,如 GeForce RTX 系列,主要为游戏玩家和内容创作者设计。它们通常在原始计算能力方面提供更好的性价比。这意味着您可以花更少的钱获得更多的计算能力,这对于业余 AI 用户或小型项目可能很有吸引力。

另一方面,专业级显卡 专为研究人员、数据科学家和企业 AI 开发人员而构建。它们更昂贵,但提供了一些可以证明更高价格合理的优势:

- 更大的 VRAM 容量: 这对于运行和训练大型模型(如 LLM)至关重要。专业卡通常比其消费级同类产品配备更多的 VRAM。

- ECC 内存: ECC(错误校正码)内存可以检测和纠正内存错误,从而提高可靠性,尤其是在长时间运行、高负载计算期间。

- 认证驱动程序: 专业卡配备的驱动程序经过专门优化和认证,适用于专业应用程序(例如 CAD、模拟)。

- 更长的产品支持: 专业卡通常会获得更长时间的支持和更新,这在企业环境中非常重要。

- 专业功能: 这些功能包括 NVLink(更快的 GPU-GPU 通信)、虚拟化支持和更好的散热解决方案。