Cartes graphiques Nvidia adaptées à l'exécution de l'IA

Beaucoup de gens associent encore principalement les cartes graphiques aux jeux vidéo, mais les GPU sont capables de bien plus. En raison de leur architecture, ils sont parfaitement adaptés aux calculs parallèles, ce qui est essentiel pour l'entraînement et l'exécution de modèles d'apprentissage profond. Prenez ceci en considération : un LLM moderne possède des milliards de paramètres, et tous ces paramètres doivent être gérés simultanément. Ce type de traitement parallèle est la véritable force des GPU, tandis que les CPU traditionnels (unités centrales de traitement) sont à la traîne à cet égard.

Quand il s'agit d'IA et de GPU, le nom Nvidia est presque synonyme. Il y a plusieurs raisons à cela, mais les plus importantes sont la plateforme CUDA et les Tensor Cores.

CUDA (Compute Unified Device Architecture) est une plateforme de calcul parallèle et un modèle de programmation développés par Nvidia. Il permet d'utiliser les GPU pour le calcul à usage général (GPGPU), et pas seulement pour les graphiques. Essentiellement, CUDA agit comme un « pont » entre le logiciel et le matériel GPU, facilitant ainsi l'exploitation de la puissance de calcul des GPU pour les développeurs. L'avantage majeur de CUDA réside dans le fait qu'il fournit un environnement relativement unifié et bien documenté, simplifiant considérablement le développement de l'IA. C'est pourquoi il est devenu la norme de l'industrie.

Les Tensor Cores sont des unités spécialisées au sein des GPU Nvidia, conçues spécifiquement pour accélérer les opérations matricielles utilisées dans l'apprentissage profond. Ces opérations constituent la base des réseaux d'apprentissage profond, et les Tensor Cores augmentent considérablement la vitesse et l'efficacité du calcul. Les nouvelles générations de Tensor Cores offrent des performances et une précision accrues.

Formats de nombres dans l'IA : pourquoi sont-ils importants ?

L'intelligence artificielle, en particulier l'apprentissage profond, nécessite d'énormes quantités de calcul. Les formats de nombres utilisés pendant ces calculs (c'est-à-dire la manière dont les nombres sont stockés et traités par l'ordinateur) influencent directement :

- Vitesse : Les formats de plus faible précision (moins de bits) permettent des calculs plus rapides.

- Besoins en mémoire : Moins de bits nécessitent moins de mémoire, ce qui est essentiel pour charger et exécuter des modèles volumineux.

- Consommation d'énergie : Le traitement de moins de bits consomme généralement moins d'énergie.

- Précision : Les formats de plus haute précision (plus de bits) donnent des résultats plus précis, mais cela peut se faire au détriment de la vitesse, de la mémoire et de la consommation d'énergie.

La prise en charge matérielle de ces formats de nombres est d'une importance capitale pour les GPU (et autres accélérateurs d'IA), car elle détermine l'efficacité fondamentale des calculs.

Architectures Nvidia par ordre chronologique pour l'exécution de l'IA

Tesla (2006)

La première architecture compatible CUDA, qui a lancé la révolution GPGPU, bien qu'elle ne comportait pas encore de Tensor Cores.

Non recommandé pour l'exécution de l'IA, peut-être seulement pour l'expérimentation si acquise à très bas prix. Pas d'accélération IA dédiée. Support CUDA limité, pilotes très anciens.

Modèles typiques : GeForce séries 8, 9, 200, 300

Fermi (2010)

Non recommandé pour l'exécution de l'IA. Peu de cœurs CUDA, faibles performances de calcul. Convient uniquement aux modèles très simples, voire pas du tout. Il est probable que cela ne vaille pas le temps et les efforts.

Modèles typiques : GeForce séries 400, 500

Kepler (2012)

Axée sur l'amélioration de l'efficacité, introduction du parallélisme dynamique. Meilleur support CUDA, mais toujours insuffisant pour l'IA moderne. Pourrait être un point d'entrée à faible budget, mais avec des compromis. Important de vérifier la prise en charge des pilotes !

Modèles professionnels typiques : Tesla K10, K20, K20X, K40 (12 Go), K80, Quadro K2000, K4000, K5000, K6000, etc. Grand public : GeForce séries 600, 700

Maxwell (2014)

L'objectif principal était une augmentation significative de l'efficacité énergétique. Efficacité énergétique améliorée, meilleures performances CUDA. Peut être utilisé pour des modèles plus petits à des résolutions inférieures.

Modèles professionnels typiques : Tesla M4, M40, M60, Quadro M2000, M4000, M5000, M6000, etc. Grand public : GeForce 750Ti, séries 900, GTX Titan X

Pascal (2016)

L'introduction de NVLink (communication GPU-GPU plus rapide) et de la prise en charge FP16 (virgule flottante demi-précision) a été une étape importante vers l'IA. Cela a marqué un progrès plus significatif pour l'IA. Convient pour exécuter des modèles de taille moyenne. La 1080 Ti est encore une carte puissante aujourd'hui. La GTX 1060 6 Go est l'entrée de gamme, tandis que les 1070, 1080 et 1080 Ti conviennent à des tâches plus sérieuses.

Modèles professionnels typiques : Tesla P4 (8 Go), P40 (24 Go), P100 (16 Go), Quadro P2000, P4000, P5000, P6000, GP100, etc. Grand public : GeForce série 10 (GTX 1060, 1070, 1080, 1080 Ti, Titan Xp)

Volta (2017)

C'est là que les Tensor Cores sont apparus pour la première fois, donnant un énorme coup de pouce aux performances de l'apprentissage profond. Du point de vue de l'exécution des LLM, cela peut être considéré comme une étape majeure. Les cartes professionnelles sont chères mais offrent d'excellentes performances en IA pour les modèles plus petits.

Tesla V100 (16/32 Go, HBM2), Quadro GV100, Titan V

Turing (2018)

Parallèlement aux cœurs Ray Tracing (RT), la prise en charge INT8 (entier 8 bits) a été introduite, visant à accélérer l'inférence. Excellent. Comporte des Tensor Cores et des cœurs Ray Tracing (RT). Convient aux projets d'IA plus sérieux (avec suffisamment de VRAM).

Modèles professionnels typiques : Tesla T4 (16 Go, GDDR6), T10, T40 (24 Go, GDDR6), Quadro RTX 4000, 5000, 6000, 8000. Grand public : GeForce RTX série 20 (RTX 2060, 2070, 2080, 2080 Ti), Titan RTX

Ampere (2020)

Cœurs RT de deuxième génération, Tensor Cores de troisième génération et introduction du format TF32 (TensorFloat-32). Convient à la plupart des tâches d'IA.

Modèles professionnels typiques : A100 (40/80 Go, HBM2e), A40 (48 Go, GDDR6), A30, A16, A10, RTX A4000, A4500, A5000, A5500, A6000, etc. Grand public : GeForce RTX série 30 (RTX 3060, RTX 3070, RTX 3080, RTX 3090 (24 Go, GDDR6x))

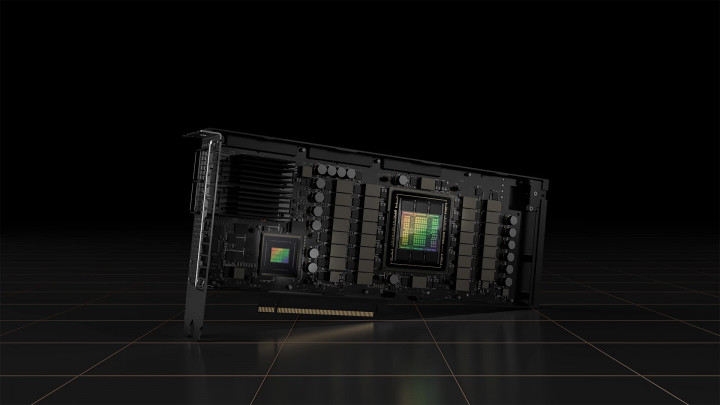

Hopper (2022)

Tensor Cores de quatrième génération, Transformer Engine (spécifiquement optimisé pour les LLM) et prise en charge FP8. Conçu pour les centres de données. Performances extraordinaires à un prix extrême.

Modèles professionnels typiques : H100 (80 Go HBM3), H200 (141 Go, HBM3e)

Ada Lovelace (2022)

Tensor Cores de quatrième génération, DLSS 3 et efficacité énergétique optimisée.

Modèles professionnels typiques : RTX 6000 Ada Generation (48 Go, GDDR6 ECC), L4, L40, L40S, etc. Grand public : GeForce RTX série 40 (RTX 4060, RTX 4070, RTX 4080, RTX 4090 (24 Go, GDDR6X))

Blackwell (2024)

La dernière génération, promettant des performances encore plus élevées, de nouveaux Tensor Cores et un NVLink amélioré. Prise en charge matérielle de FP4.

Modèles professionnels typiques : B100, B200, GB200. Grand public : GeForce RTX série 50 (Prévu : RTX 5060, RTX 5070, RTX 5080, RTX 5090 (potentiellement 32 Go GDDR7))

GPU grand public vs. professionnels

Les cartes grand public, comme la série GeForce RTX, sont principalement conçues pour les joueurs et les créateurs de contenu. Elles offrent généralement un meilleur rapport qualité-prix en termes de puissance de calcul brute. Cela signifie que vous pouvez obtenir plus de capacité de calcul pour moins d'argent, ce qui peut être intéressant pour les utilisateurs d'IA amateurs ou les petits projets.

Les cartes professionnelles, quant à elles, sont spécifiquement conçues pour les chercheurs, les scientifiques des données et les développeurs d'IA en entreprise. Elles sont plus chères, mais offrent plusieurs avantages qui peuvent justifier le prix plus élevé :

- Capacité VRAM plus importante : Ceci est crucial pour l'exécution et l'entraînement de grands modèles, tels que les LLM. Les cartes professionnelles sont souvent livrées avec beaucoup plus de VRAM que leurs homologues grand public.

- Mémoire ECC : La mémoire ECC (Error Correction Code) peut détecter et corriger les erreurs de mémoire, augmentant ainsi la fiabilité, en particulier lors de calculs de longue durée et à forte charge.

- Pilotes certifiés : Les cartes professionnelles sont livrées avec des pilotes spécifiquement optimisés et certifiés pour les applications professionnelles (par exemple, CAD, simulations).

- Support produit plus long : Les cartes professionnelles bénéficient généralement d'un support et de mises à jour pendant une période plus longue, ce qui est important dans les environnements d'entreprise.

- Fonctionnalités spécialisées : Celles-ci incluent NVLink (communication GPU-GPU plus rapide), la prise en charge de la virtualisation et de meilleures solutions de refroidissement.