86 миллиардов нейронов нашего мозга: смогут ли LLM превзойти их?

Человеческий мозг, сложная биологическая система, усовершенствованная миллионами лет эволюции, контрастирует с большими языковыми моделями (LLM) — последними достижениями в области искусственного интеллекта. Несмотря на то, что LLM демонстрируют впечатляющие возможности в обработке языка, смогут ли они когда-нибудь превзойти сложность и способности человеческого мозга?

Человеческий мозг часто считается наиболее когнитивно развитым среди млекопитающих, а его размер кажется значительно больше, чем можно было бы ожидать, исходя из размеров нашего тела. Принято считать, что количество нейронов играет ключевую роль в вычислительной мощности мозга, однако распространенное утверждение о том, что человеческий мозг содержит 100 миллиардов нейронов и в десять раз больше глиальных клеток, никогда не было научно подтверждено. Фактически, точное количество нейронов и глиальных клеток в человеческом мозге до недавнего времени оставалось неизвестным.

Согласно последним данным, мозг среднего взрослого мужчины содержит 86,1 ± 8,1 миллиарда нейронов и 84,6 ± 9,8 миллиарда ненейронных клеток (глии). Интересно, что только 19% нейронов расположены в коре головного мозга, хотя на кору приходится 82% массы человеческого мозга. Это означает, что увеличение размера коры головного мозга человека не сопровождается пропорциональным увеличением количества кортикальных нейронов.

Соотношение глиальных клеток и нейронов в различных областях человеческого мозга аналогично тому, что наблюдается у других приматов, а общее количество клеток соответствует значениям, ожидаемым для примата человеческого размера. Эти результаты опровергают широко распространенное мнение о том, что человеческий мозг имеет особый состав по сравнению с мозгом других приматов. Вместо этого они предполагают, что человеческий мозг является изометрически увеличенной версией мозга обычного примата – по сути, мозгом примата, адаптированным к размеру человека.

Это осознание открывает новую перспективу, побуждая нас пересмотреть, что же на самом деле делает человеческое мышление и когнитивные способности уникальными. Однако сегодня я подхожу к вопросу с другой стороны: можно ли сравнить наш мозг с большими языковыми моделями (LLM), например, по количеству параметров? Или, несмотря на то, что исследователи и разработчики ИИ постоянно изучают наш мозг и пытаются перенести принципы его работы в системы искусственного интеллекта, любое сравнение бессмысленно просто потому, что один является химической системой, а другой – электронной? Но сначала немного справочной информации.

Как подсчитывают нейроны?

Оценка количества нейронов – непростая задача, поскольку мозг не имеет однородной структуры. Один из подходов заключается в подсчете нейронов в определенной области мозга и последующей экстраполяции этого значения на весь мозг. Однако этот метод сопряжен с рядом проблем:

-

Неравномерное распределение

Плотность нейронов сильно варьируется в разных частях мозга. Например, мозжечок, расположенный в нижней задней части мозга, содержит около половины всех нейронов, несмотря на значительно меньший объем по сравнению с остальной частью мозга. Это связано с тем, что крошечные нейроны мозжечка отвечают за точную настройку двигательной координации и другие автоматизированные процессы. Ранее упомянутая кора головного мозга – отвечающая за высшие когнитивные функции – содержит более крупные нейроны, образующие более сложные сети. Здесь кубический миллиметр содержит приблизительно 50 000 нейронов. -

Видимость нейронов

Нейроны расположены настолько плотно и сложно переплетены, что подсчитать их по отдельности затруднительно. Классическим решением является окрашивание по Гольджи, разработанное Камилло Гольджи. Этот метод окрашивает лишь небольшую часть нейронов (обычно несколько процентов), оставляя другие клетки невидимыми. Хотя это помогает получить более подробный образец, экстраполяция результатов по-прежнему сопряжена с неопределенностями.

Последняя, более точная оценка основана на инновационной методике. Исследователи растворяют мембраны клеток мозга, создавая однородную смесь – своего рода «мозговой суп» – в которой можно различить ядра клеток мозга. Окрашивание этих ядер различными маркерами позволяет отделить нейроны от других клеток мозга, таких как глия. Этот метод, часто называемый методом изотропного фракционирования, устраняет ошибки, возникающие из-за различий в плотности между областями мозга, и обеспечивает более точный результат для всего мозга.

Хотя эта новая технология значительно снижает неопределенность предыдущих оценок, метод по-прежнему основан на выборке и экстраполяции.

Как работает человеческий мозг?

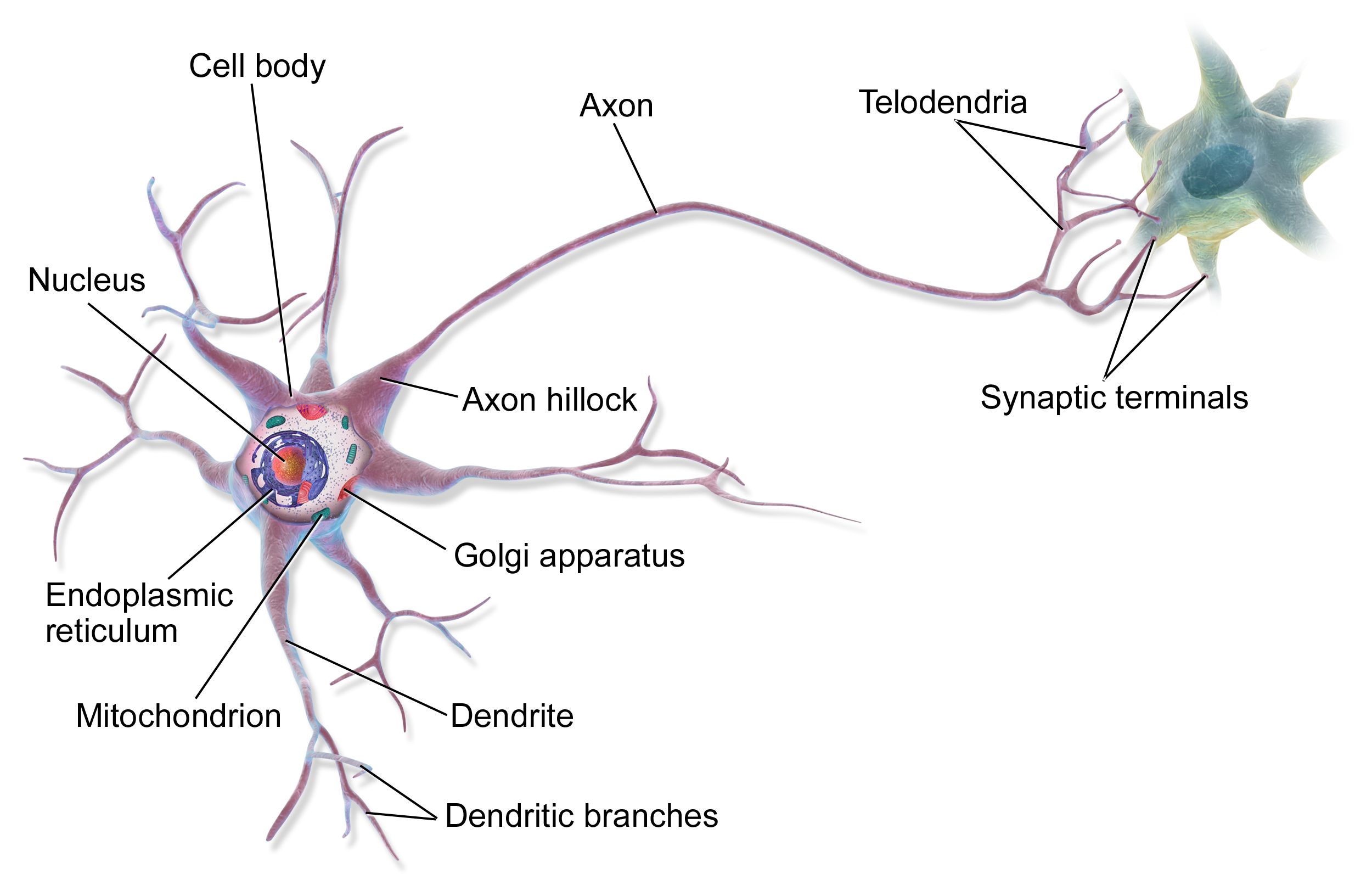

Основными строительными блоками мозга являются нейроны, которых, как мы теперь знаем, в мозге взрослого человека насчитывается около 86 миллиардов. Однако все они разные – существует множество различных типов нейронов, выполняющих различные функции. Наряду с нейронами существует примерно такое же количество глиальных клеток, которые выполняют вспомогательные функции, такие как снабжение питательными веществами и участие в иммунной защите.

Связи между нейронами, синапсы, – вот что делает мозг поистине особенным. Средний нейрон образует около 7000 синапсов с другими нейронами, что в общей сложности составляет приблизительно 600-1000 триллионов синаптических связей в мозге. Эти связи не статичны – они постоянно меняются, укрепляясь или ослабевая в процессе обучения. Это известно как синаптическая пластичность.

Источник: Wikipedia

Различные области мозга специализируются на определенных функциях (как уже упоминалось ранее). Большие полушария головного мозга являются центром сознательного мышления, восприятия и моторного планирования. Мозжечок – основная область для координации движений и процедурного обучения. Ствол мозга регулирует основные жизненные функции, а лимбическая система отвечает за эмоциональную обработку и память.

Обработка информации в мозге происходит параллельно – разные области работают над разными задачами одновременно. Информация передается посредством комбинации электрических и химических сигналов. Когда нейрон активируется, он посылает электрический импульс (потенциал действия) по своему аксону, вызывая высвобождение нейромедиаторов в синапсах. Эти химические посредники затем влияют на активность следующего нейрона.

Энергопотребление мозга поразительно эффективно – он использует всего около 20 ватт, что эквивалентно мощности энергосберегающей лампочки. Несмотря на это, мозг потребляет около 20% от общего энергопотребления организма (при этом составляя всего 2% от массы нашего тела), что указывает на то, насколько энергоемкой является обработка информации.

Активность мозга организована не только на нейронном уровне. Можно наблюдать различные частотные мозговые волны (альфа, бета, тета, дельта), отражающие синхронизированную активность больших групп нейронов. Эти ритмы играют важную роль, например, в консолидации памяти и процессах внимания.

Одним из важнейших свойств мозга является его пластичность – способность к реорганизации на протяжении всей жизни. Это является не только основой обучения, но и позволяет частично восстановиться после травмы. Нейропластичность происходит посредством различных механизмов, таких как образование новых синапсов, усиление или ослабление существующих связей и, в некоторых случаях, даже образование новых нейронов (нейрогенез).

Современные исследования показывают, что мозг связан не только с центральной нервной системой, но и тесно взаимодействует с кишечником (ось «кишечник-мозг») и в значительной степени находится под влиянием иммунной системы. Эта сложная сеть взаимодействий объясняет, почему такие факторы, как диета или стресс, оказывают столь глубокое влияние на когнитивные функции.

Наука по-прежнему сталкивается со многими вопросами относительно функций мозга. Например, мы до сих пор не понимаем, как возникает сознание или как именно хранятся и извлекаются воспоминания. Текущие крупномасштабные проекты по исследованию мозга, такие как Human Brain Project или BRAIN Initiative, обещают новые открытия в ближайшем будущем.

Как работают языковые модели?

В то время как фундаментальная архитектура человеческого мозга схожа, хотя и наблюдаются индивидуальные различия в структуре и функциях (из-за таких факторов, как нейроразнообразие или индивидуальный опыт), модели искусственного интеллекта, предназначенные для обработки языка, демонстрируют широкий спектр с точки зрения структуры и параметров. Эти различия между моделями могут возникать из-за использования различных архитектур (таких как трансформеры против рекуррентных сетей) или обучения на разных наборах данных. Однако есть некоторые области, где они более или менее совпадают. Я постараюсь обрисовать их.

Языковые модели на основе трансформеров (такие как модели GPT или Llama) в своей основе построены из блоков-трансформеров (слоев), которые содержат части кодировщика и декодировщика (или часто только части декодировщика). Каждый блок содержит несколько компонентов, выполняющих различные задачи. Наиболее важными среди них являются механизм многоголового самовнимания и слой нейронной сети прямого распространения. Помимо этих компонентов, нормализация слоев, dropout и позиционное кодирование также играют важную роль. Суть механизма самовнимания заключается в том, что он динамически изучает взаимосвязи между входными словами, а сеть прямого распространения выполняет нелинейное преобразование.

Когда мы говорим о количестве параметров (одном из наиболее важных определяющих факторов языковых моделей, часто даже включаемом в название модели), мы фактически имеем в виду сумму обучаемых весов и смещений модели. Эти параметры определяют, как модель обрабатывает информацию, и оптимизируются в процессе обучения (процессе обучения). Количество параметров зависит от нескольких факторов:

-

Количество блоков-трансформеров: Более крупные модели обычно содержат больше блоков-трансформеров. Например, GPT-3 с 175 миллиардами параметров [^1] использует 96 блоков (слоев), в то время как версия Llama 2 с 70 миллиардами параметров использует 80 блоков. Глубина блоков существенно влияет на количество параметров.

-

Размер скрытого состояния: Это вектор, представляющий информацию внутри данного блока и определяющий, сколько информации модель может обработать одновременно. Чем больше это число, тем больше параметров требуется в блоках-трансформерах.

-

Количество голов внимания: Многоголовое внимание позволяет модели анализировать один и тот же вход с разных точек зрения. Каждая голова внимания требует дополнительных параметров.

Рассматривая конкретные цифры: в типичном блоке-трансформере параметры распределены между:

-

Матрицами весов механизма внимания (матрицы Query, Key, Value)

-

Весами и смещениями нейронной сети прямого распространения

-

Параметрами масштабирования и сдвига нормализации слоев

-

Параметрами для позиционного кодирования (как для изученных, так и для синусоидальных версий)

Интересным аспектом является вычислительная сложность: вычислительные затраты механизма самовнимания растут квадратично с увеличением длины последовательности. Это означает, что, хотя модель имеет много параметров, не все параметры активны одновременно во время фактической обработки. Методы разреженного внимания пытаются решить эту проблему.

Следовательно, количество параметров само по себе не обязательно является хорошей мерой возможностей модели. Меньшая модель с лучшей архитектурой часто может превзойти большую, но менее эффективную модель. Производительность модели также оценивается с использованием таких метрик, как точность, F1-мера, BLEU score или PERPLEXITY. Это похоже на то, как в человеческом мозге важно не только количество нейронов или синапсов, но и их организация и качество связей между ними.

Можно ли сравнить мозг с языковой моделью на основе конкретных значений?

Хотя может возникнуть соблазн оценить текущий уровень искусственного интеллекта, сравнив его производительность и знания с нашим мозгом, приведенные выше описания показывают, что, хотя основным источником для разработки искусственных систем является изучение структуры и функций нашего мозга (поскольку это рабочий пример – как бы тривиально это ни звучало, это важный факт), сравнение далеко не прямолинейно. Непосредственное сравнение параметров LLM с количеством нейронов или синапсов нецелесообразно, поскольку две системы основаны на принципиально разных принципах работы и архитектурах. Однако, несмотря на фундаментальные различия, между двумя системами можно провести некоторые аналогии.

Нейроны vs. Слои LLM

-

Слои LLM в некоторой степени напоминают иерархическую структуру мозга, где обработка информации происходит на нескольких уровнях. Однако в мозге иерархия более функциональна и разделена на специализированные области, тогда как в LLM слои представляют собой уровни абстракции.

-

Нейроны являются локально независимыми единицами, но глобально организованы в сети, в то время как слои LLM глобально взаимозависимы через механизм внимания. Само-внимание обеспечивает глобальный поток информации внутри слоя.

Синапсы vs. Параметры LLM

-

Параметры LLM похожи на синапсы в том смысле, что и те, и другие влияют на силу информационного потока, хотя и посредством различных механизмов.

-

Синапсы динамически изменяются и адаптируются, тогда как параметры LLM статичны после обучения. Тонкая настройка позволяет параметрам снова изменяться, но это все равно не соответствует динамической природе синапсов. Сила синапсов изменяется посредством долговременной потенциации (LTP) или долговременной депрессии (LTD), которые являются динамическими биоэлектрохимическими процессами.

Что лучше представляет параметры LLM?

-

Ни нейроны, ни синапсы не представляют параметры LLM точно, но ближайшая аналогия – это синапсы, поскольку они также регулируют связи и силу информационного потока. Используя этот подход, интересно отметить, что количество синапсов в мозге на несколько порядков больше (100-1000 триллионов синапсов по сравнению с 70 миллиардами до потенциально более 1 триллиона параметров в крупнейших LLM).

-

Однако синапсы гораздо сложнее и динамичнее, чем параметры LLM. Синапсы – это не просто простые веса; они регулируют связи посредством сложных биоэлектрохимических процессов, которые динамически изменяются в зависимости от активности и опыта.

Почему аналогия неточна?

-

Операционные различия:

-

Мозг демонстрирует биологический параллелизм и обрабатывает непрерывные сигналы, в то время как LLM полагаются на дискретные, цифровые вычисления, выполняемые числовыми процессорами (GPU/TPU). В мозге вычисления осуществляются биохимическими процессами и электрическими сигналами.

-

-

Механизм обучения:

-

Обучение мозга динамично и эффективно даже при небольшом количестве данных. Распознавание образов и подкрепление играют решающую роль. Человеческое обучение часто бывает однократным или малократным, что позволяет обобщать на основе нескольких примеров. Обучение с подкреплением также важно в мозге.

-

Обучение LLM требует огромных объемов данных и вычислительных ресурсов. LLM менее способны к обобщению на основе нескольких примеров.

-

-

Энергоэффективность:

-

Мозг чрезвычайно энергоэффективен. Обучение и запуск LLM являются чрезвычайно энергоемкими, на порядки величины превышая энергопотребление человеческого мозга.

-

-

Представление:

-

Представления в мозге распределены и динамичны, в то время как в LLM они больше похожи на статические векторы.

-

Мозг связан с сознанием и субъективным опытом, которых в настоящее время нет у LLM.

-

-

Архитектура:

-

Иерархическая организация мозга гораздо сложнее и модульная, с различными областями, выполняющими различные функции. Эта модульность менее выражена в LLM.

-

Петли обратной связи играют важную роль в мозге, тогда как это менее характерно для большинства LLM.

-

-

Адаптация и гибкость:

-

Мозг обладает высокой адаптивностью и гибкостью благодаря нейропластичности, в то время как LLM менее способны адаптироваться к изменениям после обучения.

-

Мозг может адаптироваться к окружающей среде, что менее очевидно в LLM.

-

-

Эмоции и мотивация:

-

Эмоции играют жизненно важную роль в принятии решений и обучении в мозге, это измерение отсутствует в LLM.

-

Мотивация имеет решающее значение для поведения в мозге, еще одно измерение, отсутствующее в LLM.

-

Резюме

Как мы увидели, хотя между слоями LLM и иерархической структурой мозга или между параметрами LLM и синапсами можно провести определенные аналогии, эти аналогии ограничены. Таким образом, на вопрос, поставленный в заголовке статьи: «86 миллиардов нейронов нашего мозга: смогут ли LLM превзойти их?», нет однозначного ответа.

Две системы основаны на принципиально разных принципах работы и архитектурах. LLM лишены сознания, субъективного опыта и не могут обобщать на основе нескольких примеров так, как это может мозг.

Будущие исследования в области искусственного интеллекта, вероятно, будут сосредоточены на дальнейшем развитии возможностей LLM, потенциально приближая их к тому, как функционирует человеческий мозг. Это может включать разработку более динамичных механизмов обучения, повышение энергоэффективности, улучшение способностей к обобщению и, возможно, реализацию некоторой формы сознания. Более глубокое понимание функций мозга может помочь разработать более эффективные и интеллектуальные системы ИИ.

Однако важно помнить, что LLM не являются копиями человеческого мозга, а представляют собой иной путь к достижению интеллекта. Понимание различий между двумя системами необходимо для ответственного и эффективного использования возможностей, предоставляемых искусственным интеллектом. В будущем синергия между нейронаукой и искусственным интеллектом может открыть новые горизонты для обеих областей.

Источники:

- https://pubmed.ncbi.nlm.nih.gov/19226510/

- https://www.nature.com/scitable/blog/brain-metrics/are_there_really_as_many/

- https://www.sciencealert.com/scientists-quantified-the-speed-of-human-thought-and-its-a-big-surprise

- https://www.ndtv.com/science/human-brains-are-not-as-fast-as-we-previously-thought-study-reveals-7323078

- https://www.sciencealert.com/physics-study-overturns-a-100-year-old-assumption-on-how-brains-work

[^1]: Примечание: Хотя 175B является широко цитируемой цифрой для оригинального GPT-3, количество параметров для более новых моделей или конкретных версий может варьироваться и иногда официально не разглашается.