Tarjetas Gráficas Nvidia Adecuadas para Ejecutar IA

Mucha gente todavía asocia las tarjetas gráficas principalmente con los videojuegos, pero las GPUs son capaces de mucho más. Debido a su arquitectura, son excelentes para la computación paralela, que es esencial para entrenar y ejecutar modelos de aprendizaje profundo. Considera esto: un LLM moderno tiene miles de millones de parámetros, y todos estos parámetros deben gestionarse simultáneamente. Este tipo de procesamiento paralelo es la verdadera fortaleza de las GPUs, mientras que las CPUs tradicionales (unidades centrales de procesamiento) se quedan atrás en este aspecto.

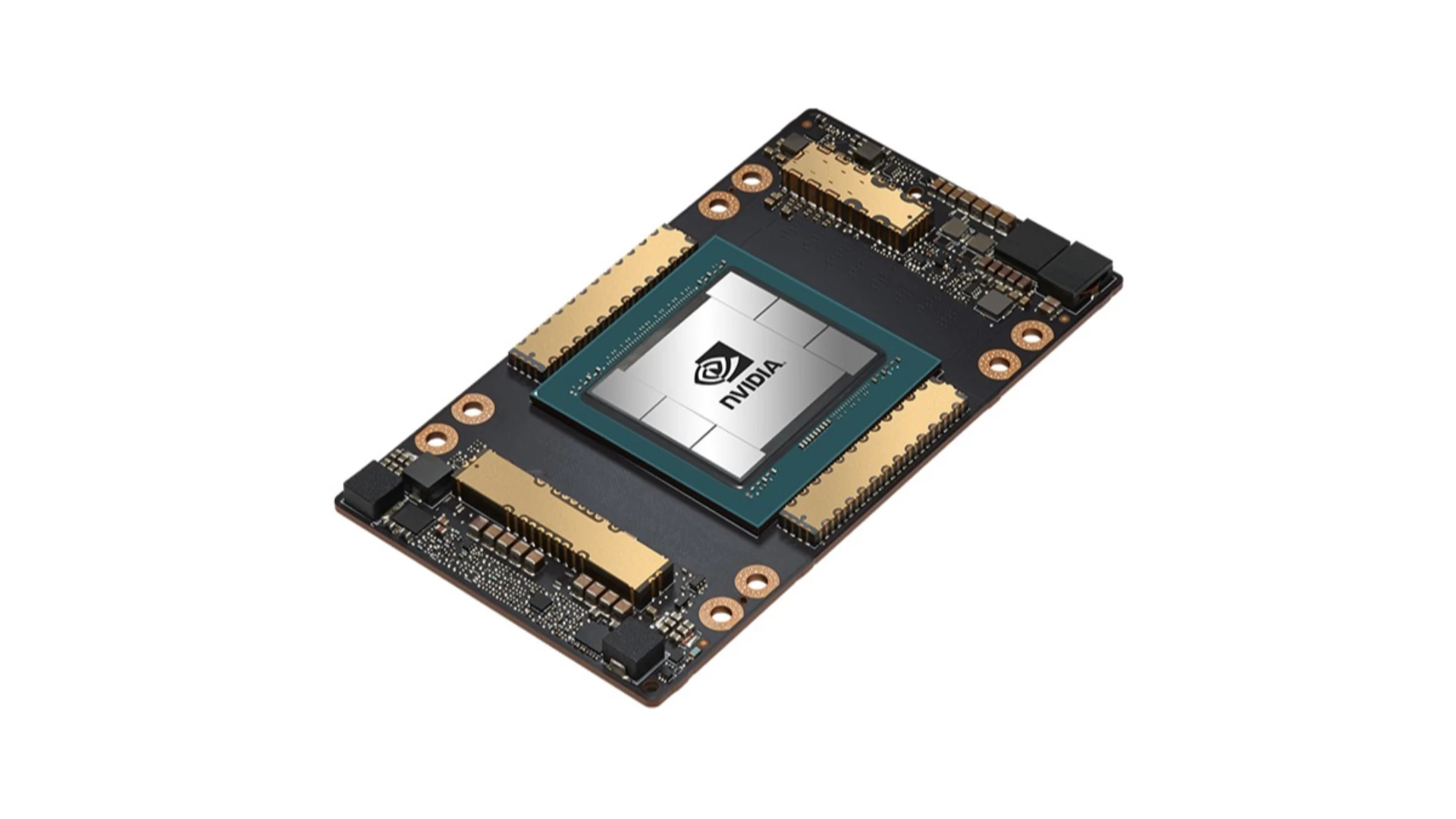

Cuando se trata de IA y GPUs, el nombre Nvidia es casi sinónimo. Hay varias razones para esto, pero las más importantes son la plataforma CUDA y los Tensor Cores.

CUDA (Compute Unified Device Architecture) es una plataforma de computación paralela y un modelo de programación desarrollado por Nvidia. Permite que las GPUs se utilicen para la computación de propósito general (GPGPU), no solo para gráficos. Esencialmente, CUDA actúa como un "puente" entre el software y el hardware de la GPU, lo que facilita a los desarrolladores aprovechar la potencia computacional de las GPUs. Para mí, la mayor ventaja de CUDA es que proporciona un entorno relativamente unificado y bien documentado, lo que simplifica significativamente el desarrollo de la IA. Esta es la razón por la que se convirtió en el estándar de la industria.

Tensor Cores son unidades especializadas dentro de las GPUs de Nvidia diseñadas específicamente para acelerar las operaciones matriciales utilizadas en el aprendizaje profundo. Estas operaciones forman la base de las redes de aprendizaje profundo, y los Tensor Cores aumentan significativamente la velocidad y la eficiencia computacional. Las nuevas generaciones de Tensor Cores ofrecen mayor rendimiento y precisión.

Formatos Numéricos en la IA: ¿Por Qué Son Importantes?

La inteligencia artificial, especialmente el aprendizaje profundo, requiere enormes cantidades de computación. Los formatos numéricos utilizados durante estos cálculos (es decir, cómo se almacenan y manejan los números en el ordenador) influyen directamente en:

- Velocidad: Los formatos de menor precisión (menos bits) permiten cálculos más rápidos.

- Requisitos de Memoria: Menos bits requieren menos memoria, lo cual es fundamental para cargar y ejecutar modelos grandes.

- Consumo de Energía: Procesar menos bits generalmente consume menos energía.

- Precisión: Los formatos de mayor precisión (más bits) producen resultados más precisos, pero esto puede tener un coste en velocidad, memoria y energía.

El soporte de hardware para estos formatos numéricos es de vital importancia para las GPUs (y otros aceleradores de IA) porque determina la eficiencia fundamental de los cálculos.

Arquitecturas de Nvidia en Orden Cronológico para la Ejecución de IA

Tesla (2006)

La primera arquitectura compatible con CUDA, que lanzó la revolución GPGPU, aunque todavía no contaba con Tensor Cores.

No recomendada para la ejecución de IA, quizás solo para experimentación si se adquiere muy barata. Sin aceleración de IA dedicada. Soporte CUDA limitado, drivers muy antiguos.

Modelos típicos: series GeForce 8, 9, 200, 300

Fermi (2010)

No recomendada para la ejecución de IA. Pocos núcleos CUDA, bajo rendimiento computacional. Adecuada solo para modelos muy simples, si acaso. Probablemente no valga la pena el tiempo y el esfuerzo.

Modelos típicos: series GeForce 400, 500

Kepler (2012)

Centrada en mejorar la eficiencia, introdujo el paralelismo dinámico. Mejor soporte CUDA, pero aún insuficiente para la IA moderna. Podría ser un punto de entrada de bajo presupuesto, pero con compromisos. ¡Importante verificar el soporte de drivers!

Modelos profesionales típicos: Tesla K10, K20, K20X, K40 (12 GB), K80, Quadro K2000, K4000, K5000, K6000, etc. Consumo: series GeForce 600, 700

Maxwell (2014)

El objetivo principal era un aumento significativo en la eficiencia energética. Eficiencia energética mejorada, mejor rendimiento CUDA. Se puede utilizar para modelos más pequeños a resoluciones más bajas.

Modelos profesionales típicos: Tesla M4, M40, M60, Quadro M2000, M4000, M5000, M6000, etc. Consumo: GeForce 750Ti, series 900, GTX Titan X

Pascal (2016)

La introducción de NVLink (comunicación GPU-GPU más rápida) y el soporte FP16 (punto flotante de media precisión) fue un paso importante hacia la IA. Esto marcó un avance más significativo para la IA. Adecuada para ejecutar modelos de tamaño mediano. La 1080 Ti sigue siendo una tarjeta potente hoy en día. La GTX 1060 de 6 GB es de nivel de entrada, mientras que la 1070, 1080 y 1080 Ti son adecuadas para tareas más serias.

Modelos profesionales típicos: Tesla P4 (8GB), P40 (24GB), P100 (16GB), Quadro P2000, P4000, P5000, P6000, GP100, etc. Consumo: serie GeForce 10 (GTX 1060, 1070, 1080, 1080 Ti, Titan Xp)

Volta (2017)

Aquí es donde aparecieron por primera vez los Tensor Cores, dando un gran impulso al rendimiento del aprendizaje profundo. Desde la perspectiva de ejecutar LLMs, esto puede considerarse un hito importante. Las tarjetas profesionales son caras pero ofrecen un excelente rendimiento de IA para modelos más pequeños.

Tesla V100 (16/32GB, HBM2), Quadro GV100, Titan V

Turing (2018)

Junto con los núcleos Ray Tracing (RT), se introdujo el soporte INT8 (entero de 8 bits), destinado a acelerar la inferencia. Excelente. Cuenta con Tensor Cores y núcleos Ray Tracing (RT). Adecuada para proyectos de IA más serios (con suficiente VRAM).

Modelos profesionales típicos: Tesla T4 (16GB, GDDR6), T10, T40 (24GB, GDDR6), Quadro RTX 4000, 5000, 6000, 8000. Consumo: serie GeForce RTX 20 (RTX 2060, 2070, 2080, 2080 Ti), Titan RTX

Ampere (2020)

Núcleos RT de segunda generación, Tensor Cores de tercera generación y la introducción del formato TF32 (TensorFloat-32). Adecuada para la mayoría de las tareas de IA.

Modelos profesionales típicos: A100 (40/80GB, HBM2e), A40 (48GB, GDDR6), A30, A16, A10, RTX A4000, A4500, A5000, A5500, A6000, etc. Consumo: serie GeForce RTX 30 (RTX 3060, RTX 3070, RTX 3080, RTX 3090 (24GB, GDDR6x))

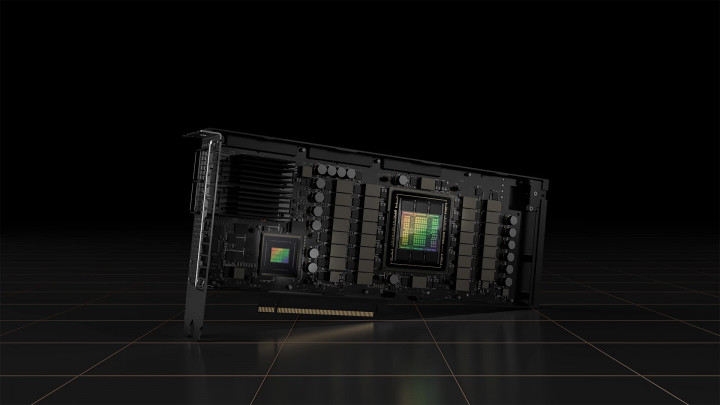

Hopper (2022)

Tensor Cores de cuarta generación, Transformer Engine (específicamente optimizado para LLMs) y soporte FP8. Diseñada para centros de datos. Rendimiento extraordinario a un precio extremo.

Modelos profesionales típicos: H100 (80GB HBM3), H200 (141GB, HBM3e)

Ada Lovelace (2022)

Tensor Cores de cuarta generación, DLSS 3 y eficiencia energética optimizada.

Modelos profesionales típicos: RTX 6000 Ada Generation (48GB, GDDR6 ECC), L4, L40, L40S, etc. Consumo: serie GeForce RTX 40 (RTX 4060, RTX 4070, RTX 4080, RTX 4090 (24GB, GDDR6X))

Blackwell (2024)

La última generación, que promete un rendimiento aún mayor, nuevos Tensor Cores y NVLink mejorado. Soporte de hardware para FP4.

Modelos profesionales típicos: B100, B200, GB200. Consumo: serie GeForce RTX 50 (Se espera: RTX 5060, RTX 5070, RTX 5080, RTX 5090 (potencialmente 32GB GDDR7))

GPUs de Consumo vs. Profesionales

Las tarjetas de consumo, como la serie GeForce RTX, están diseñadas principalmente para jugadores y creadores de contenido. Generalmente ofrecen una mejor relación precio-rendimiento en términos de potencia computacional bruta. Esto significa que puedes obtener más capacidad de cómputo por menos dinero, lo que puede ser atractivo para usuarios de IA aficionados o proyectos más pequeños.

Las tarjetas profesionales, por otro lado, están construidas específicamente para investigadores, científicos de datos y desarrolladores de IA empresariales. Son más caras, pero ofrecen varias ventajas que pueden justificar el precio más alto:

- Mayor Capacidad de VRAM: Esto es crucial para ejecutar y entrenar modelos grandes, como los LLMs. Las tarjetas profesionales a menudo vienen con significativamente más VRAM que sus contrapartes de consumo.

- Memoria ECC: La memoria ECC (Código de Corrección de Errores) puede detectar y corregir errores de memoria, lo que aumenta la fiabilidad, especialmente durante cálculos de larga duración y alta carga.

- Drivers Certificados: Las tarjetas profesionales vienen con drivers que están específicamente optimizados y certificados para aplicaciones profesionales (por ejemplo, CAD, simulaciones).

- Soporte de Producto Más Largo: Las tarjetas profesionales suelen recibir soporte y actualizaciones durante un período más largo, lo cual es importante en entornos empresariales.

- Características Especializadas: Estas incluyen NVLink (comunicación GPU-GPU más rápida), soporte de virtualización y mejores soluciones de refrigeración.