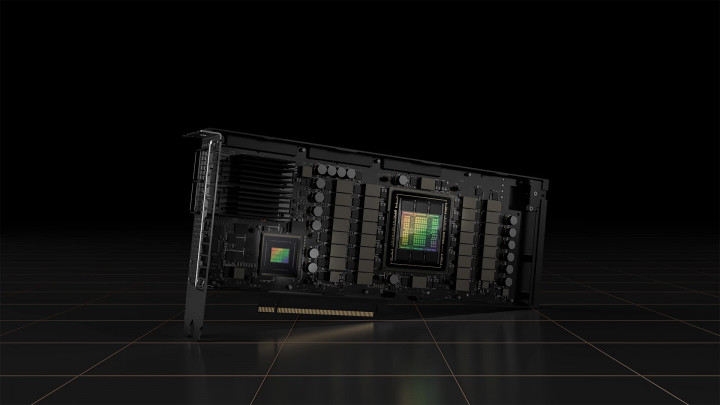

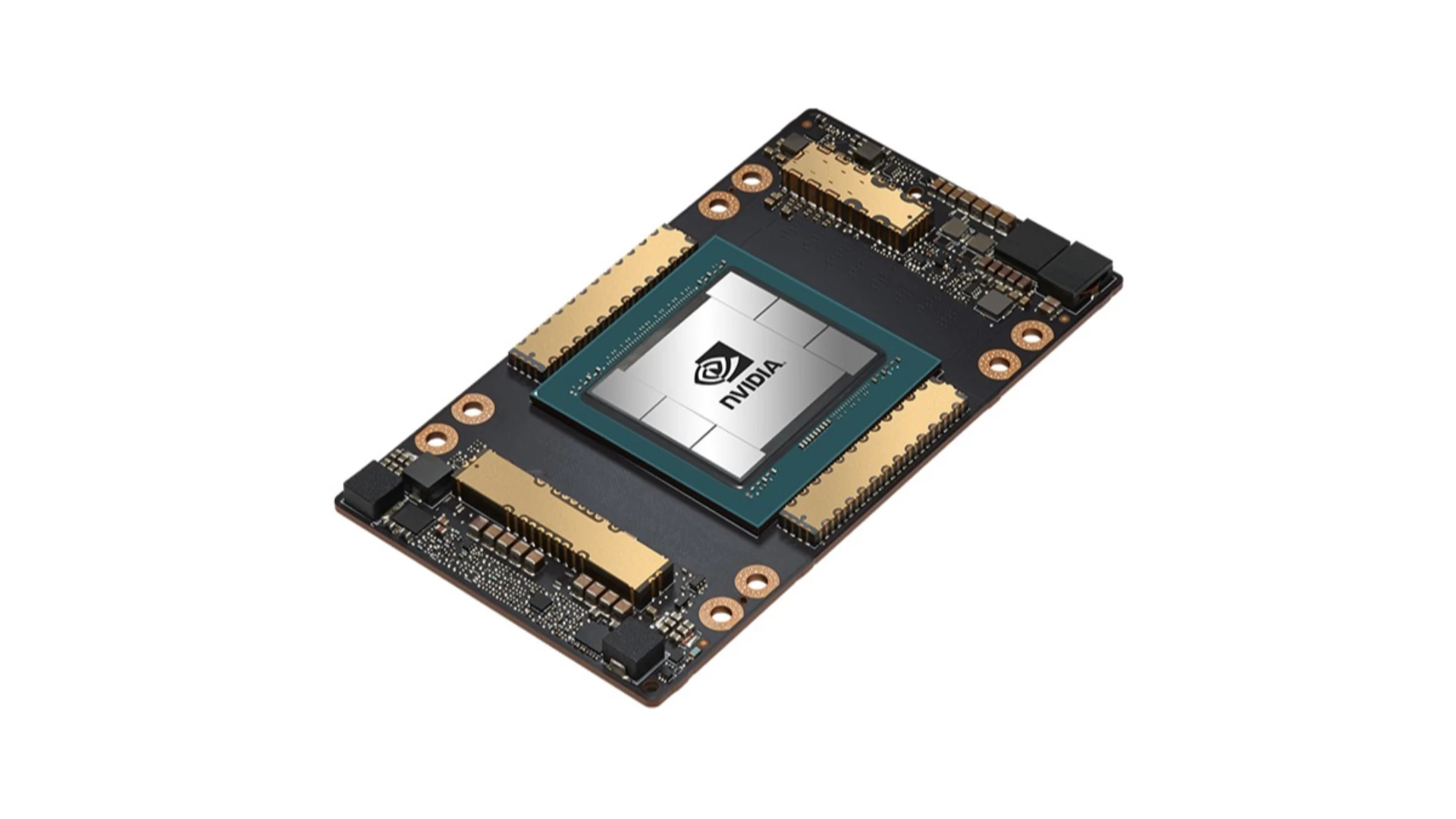

Видеокарты Nvidia, подходящие для запуска ИИ

Многие до сих пор ассоциируют видеокарты в первую очередь с играми, однако GPU способны на гораздо большее. Благодаря своей архитектуре они отлично подходят для параллельных вычислений, что необходимо для обучения и запуска моделей глубокого обучения. Задумайтесь: современная большая языковая модель (LLM) имеет миллиарды параметров, и всеми этими параметрами нужно управлять одновременно. Такая параллельная обработка данных – истинная сила GPU, в то время как традиционные CPU (центральные процессоры) в этом отношении отстают.

Когда речь заходит об ИИ и GPU, имя Nvidia становится практически синонимом. Этому есть несколько причин, но самые важные – платформа CUDA и Tensor Cores.

CUDA (Compute Unified Device Architecture) – это платформа параллельных вычислений и модель программирования, разработанная Nvidia. Она позволяет использовать GPU для вычислений общего назначения (GPGPU), а не только для графики. По сути, CUDA действует как «мост» между программным обеспечением и аппаратным обеспечением GPU, облегчая разработчикам использование вычислительной мощности GPU. Для меня самое большое преимущество CUDA заключается в том, что она обеспечивает относительно унифицированную и хорошо документированную среду, значительно упрощая разработку ИИ. Именно поэтому она стала отраслевым стандартом.

Tensor Cores – это специализированные блоки внутри GPU Nvidia, разработанные специально для ускорения матричных операций, используемых в глубоком обучении. Эти операции составляют основу нейронных сетей глубокого обучения, и Tensor Cores значительно повышают скорость и эффективность вычислений. Новые поколения Tensor Cores предлагают еще большую производительность и точность.

Форматы чисел в ИИ: почему это важно?

Искусственный интеллект, особенно глубокое обучение, требует огромных вычислительных ресурсов. Форматы чисел, используемые во время этих вычислений (то есть, как числа хранятся и обрабатываются компьютером), напрямую влияют на:

- Скорость: форматы с более низкой точностью (меньшим количеством бит) обеспечивают более быстрые вычисления.

- Требования к памяти: меньшее количество бит требует меньше памяти, что критически важно для загрузки и запуска больших моделей.

- Энергопотребление: обработка меньшего количества бит обычно потребляет меньше энергии.

- Точность: форматы с более высокой точностью (большим количеством бит) дают более точные результаты, но это может достигаться за счет скорости, памяти и энергопотребления.

Аппаратная поддержка этих форматов чисел критически важна для GPU (и других ускорителей ИИ), поскольку она определяет фундаментальную эффективность вычислений.

Больше информации о распространенных форматах чисел в ИИ и важности аппаратной поддержки.

Архитектуры Nvidia в хронологическом порядке для выполнения ИИ

Tesla (2006)

Первая архитектура с поддержкой CUDA, которая запустила революцию GPGPU, хотя в ней еще не было Tensor Cores.

Не рекомендуется для выполнения ИИ, разве что для экспериментов, если приобретена очень дешево. Нет выделенного ускорения ИИ. Ограниченная поддержка CUDA, очень старые драйверы.

Типичные модели: GeForce 8, 9, 200, 300 серии

Fermi (2010)

Не рекомендуется для выполнения ИИ. Мало ядер CUDA, низкая вычислительная производительность. Подходит только для очень простых моделей, если вообще подходит. Вероятно, не стоит потраченного времени и усилий.

Типичные модели: GeForce 400, 500 серии

Kepler (2012)

Сосредоточена на повышении эффективности, введена динамическая параллельность. Лучшая поддержка CUDA, но все еще недостаточно для современного ИИ. Может быть бюджетным вариантом начального уровня, но с компромиссами. Важно проверить поддержку драйверов!

Типичные профессиональные модели: Tesla K10, K20, K20X, K40 (12 GB), K80, Quadro K2000, K4000, K5000, K6000 и т. д. Потребительские: GeForce 600, 700 серии

Maxwell (2014)

Основной целью было значительное увеличение энергоэффективности. Улучшенная энергоэффективность, лучшая производительность CUDA. Можно использовать для небольших моделей при более низких разрешениях.

Типичные профессиональные модели: Tesla M4, M40, M60, Quadro M2000, M4000, M5000, M6000 и т. д. Потребительские: GeForce 750Ti, 900 серии, GTX Titan X

Pascal (2016)

Внедрение NVLink (более быстрая связь GPU-GPU) и поддержка FP16 (полуточной плавающей запятой) стало важным шагом на пути к ИИ. Это ознаменовало более значительный шаг вперед для ИИ. Подходит для запуска моделей среднего размера. 1080 Ti до сих пор остается мощной картой. GTX 1060 6GB – начальный уровень, а 1070, 1080 и 1080 Ti подходят для более серьезных задач.

Типичные профессиональные модели: Tesla P4 (8GB), P40 (24GB), P100 (16GB), Quadro P2000, P4000, P5000, P6000, GP100 и т. д. Потребительские: GeForce 10 series (GTX 1060, 1070, 1080, 1080 Ti, Titan Xp)

Volta (2017)

Здесь впервые появились Tensor Cores, что дало огромный прирост производительности в глубоком обучении. С точки зрения запуска LLM это можно считать важной вехой. Профессиональные карты дороги, но предлагают отличную производительность ИИ для небольших моделей.

Tesla V100 (16/32GB, HBM2), Quadro GV100, Titan V

Turing (2018)

Наряду с ядрами Ray Tracing (RT) была введена поддержка INT8 (8-битное целое число), направленная на ускорение инференса. Отлично. Имеет Tensor Cores и ядра Ray Tracing (RT). Подходит для более серьезных проектов ИИ (с достаточным объемом VRAM).

Типичные профессиональные модели: Tesla T4 (16GB, GDDR6), T10, T40 (24GB, GDDR6), Quadro RTX 4000, 5000, 6000, 8000. Потребительские: GeForce RTX 20 series (RTX 2060, 2070, 2080, 2080 Ti), Titan RTX

Ampere (2020)

Ядра RT второго поколения, Tensor Cores третьего поколения и введение формата TF32 (TensorFloat-32). Подходит для большинства задач ИИ.

Типичные профессиональные модели: A100 (40/80GB, HBM2e), A40 (48GB, GDDR6), A30, A16, A10, RTX A4000, A4500, A5000, A5500, A6000 и т. д. Потребительские: GeForce RTX 30 series (RTX 3060, RTX 3070, RTX 3080, RTX 3090 (24GB, GDDR6x))

Hopper (2022)

Tensor Cores четвертого поколения, Transformer Engine (специально оптимизированный для LLM) и поддержка FP8. Разработан для центров обработки данных. Экстраординарная производительность по экстремальной цене.

Типичные профессиональные модели: H100 (80GB HBM3), H200 (141GB, HBM3e)

Ada Lovelace (2022)

Tensor Cores четвертого поколения, DLSS 3 и оптимизированная энергоэффективность.

Типичные профессиональные модели: RTX 6000 Ada Generation (48GB, GDDR6 ECC), L4, L40, L40S и т. д. Потребительские: GeForce RTX 40 series (RTX 4060, RTX 4070, RTX 4080, RTX 4090 (24GB, GDDR6X))

Blackwell (2024)

Последнее поколение, обещающее еще большую производительность, новые Tensor Cores и улучшенный NVLink. Аппаратная поддержка FP4.

Типичные профессиональные модели: B100, B200, GB200. Потребительские: GeForce RTX 50 series (Ожидается: RTX 5060, RTX 5070, RTX 5080, RTX 5090 (потенциально 32GB GDDR7))

Потребительские и профессиональные GPU

Потребительские карты, такие как серия GeForce RTX, в первую очередь предназначены для геймеров и создателей контента. Они обычно предлагают лучшее соотношение цены и производительности с точки зрения чистой вычислительной мощности. Это означает, что вы можете получить больше вычислительных возможностей за меньшие деньги, что может быть привлекательно для любителей ИИ или небольших проектов.

Профессиональные карты, с другой стороны, специально созданы для исследователей, специалистов по данным и корпоративных разработчиков ИИ. Они дороже, но предлагают ряд преимуществ, которые могут оправдать более высокую цену:

- Больший объем VRAM: это крайне важно для запуска и обучения больших моделей, таких как LLM. Профессиональные карты часто поставляются со значительно большим объемом VRAM, чем их потребительские аналоги.

- Память ECC: память ECC (Error Correction Code) может обнаруживать и исправлять ошибки памяти, повышая надежность, особенно во время длительных вычислений с высокой нагрузкой.

- Сертифицированные драйверы: профессиональные карты поставляются с драйверами, которые специально оптимизированы и сертифицированы для профессиональных приложений (например, CAD, симуляции).

- Более длительная поддержка продукта: профессиональные карты обычно получают поддержку и обновления в течение более длительного периода, что важно в корпоративной среде.

- Специализированные функции: к ним относятся NVLink (более быстрая связь GPU-GPU), поддержка виртуализации и лучшие решения для охлаждения.