Nvidia stellt Blackwell vor: Die KI-Superchip-Plattform der nächsten Generation

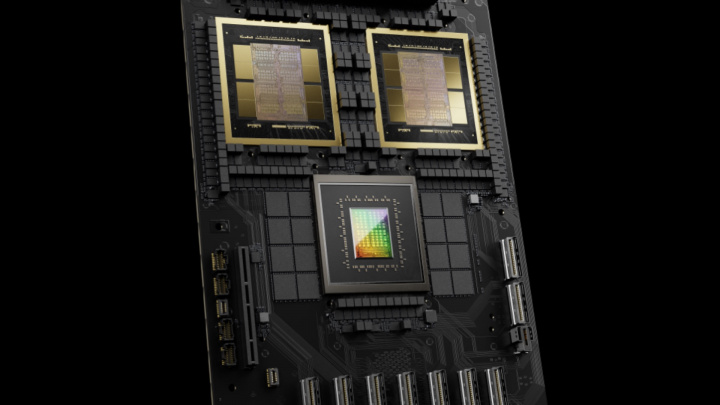

Nvidia, ein führendes Unternehmen im Bereich Accelerated Computing und KI, hat seine mit Spannung erwartete Plattform der nächsten Generation vorgestellt, die auf der leistungsstarken Blackwell GPU basiert. Diese neue Architektur, die auf der GTC 2024 Konferenz des Unternehmens angekündigt und nach dem Mathematiker David Blackwell benannt wurde, folgt auf die einflussreiche Hopper-Generation (H100/H200). Bedeutenderweise stellt Blackwell Nvidias ersten Vorstoß in ein Chiplet-basiertes Design für seine Rechenzentrums-GPUs dar, bei dem zwei große GPU-Dies integriert werden, die mit einem kundenspezifischen TSMC 4NP Prozess Knoten gefertigt werden.

Die Blackwell-Plattform ermöglicht es Unternehmen, beispiellos große KI-Modelle zu entwickeln und auszuführen, die potenziell auf Billionen von Parametern skalieren. Diese Fähigkeit ist entscheidend für Durchbrüche in komplexen Bereichen wie Datenverarbeitung, Ingenieursimulation, elektronische Designautomatisierung (EDA), computergestütztes Wirkstoffdesign, Quantencomputing und dem sich schnell entwickelnden Bereich der generativen KI.

Die Blackwell-Architektur führt mehrere wichtige Innovationen ein, die darauf abzielen, die immensen Rechenanforderungen moderner KI zu bewältigen:

- Sie beinhaltet sechs transformative Technologien, die speziell entwickelt wurden, um die Fähigkeiten des Accelerated Computing für KI, Datenanalyse und High-Performance Computing (HPC) zu verbessern. Dazu gehören Fortschritte wie eine dedizierte RAS (Reliability, Availability, Serviceability) Engine für verbesserte Systemverfügbarkeit und eine Secure AI-Funktion, die vertrauliche Rechenfunktionen bietet.

- Verfügt über neue Tensor-Kerne und einen verbesserten TensorRT-LLM Compiler. Zusammen können diese die Betriebskosten und den Energieverbrauch für Inferenz auf großen Sprachmodellen (LLMs) um bis zu 25 Mal im Vergleich zur vorherigen Hopper-Generation senken.

- Die Plattform hat bereits starke Unterstützung von wichtigen Branchenakteuren erhalten, darunter Amazon Web Services (AWS), Dell Technologies, Google, Meta, Microsoft, OpenAI, Oracle, Tesla und xAI, was auf eine breite und schnelle Akzeptanz in der Cloud- und Unternehmensbranche hindeutet.

Wichtigste technologische Innovationen:

- Eine Transformer Engine der zweiten Generation nutzt neue Micro-Tensor-Skalierungsunterstützung und integriert fortschrittliche Algorithmen für das dynamische Bereichsmanagement mit der neuartigen 4-Bit-Gleitkomma-Präzision (FP4). Dies ermöglicht eine Verdopplung der Rechenleistung und der Modellgrößenkapazitäten bei gleichzeitiger Aufrechterhaltung einer hohen Genauigkeit, was für das Training und die Ausführung massiver Foundation-Modelle unerlässlich ist.

- Beinhaltet NVIDIAs NVLink der fünften Generation, eine Hochgeschwindigkeits-Verbindungstechnologie. Sie liefert einen bahnbrechenden bidirektionalen Durchsatz von 1,8 Terabyte pro Sekunde (TB/s) pro GPU. Dies ermöglicht eine nahtlose Hochbandbreitenkommunikation zwischen bis zu 576 GPUs innerhalb großer Serverracks, die über das neue NVLink Switch 7.2T-System verbunden sind, was für das Training von Modellen mit mehr als Billionen von Parametern entscheidend ist.

- Eine dedizierte Decompression Engine beschleunigt Datenbankabfragen und Datenanalysen durch die Unterstützung der neuesten Formate und beschleunigt so die Datenverarbeitungsaufgaben erheblich, die oft Engpässe in KI-Workflows darstellen.

Anwendung der Blackwell-Plattform:

- Der DGX SuperPOD™ powered by NVIDIA GB200 Grace Blackwell Superchips stellt den nächsten Sprung in der KI-Supercomputing-Infrastruktur dar. Er ist speziell für die Verarbeitung von generativen KI-Modellen mit Billionen von Parametern konzipiert und bietet massive Leistung, Skalierbarkeit auf bis zu Zehntausende von GPUs und hohe Energieeffizienz in einem flüssigkeitsgekühlten Rack-Scale-Design.

- Der GB200 Grace Blackwell Superchip selbst verbindet zwei Blackwell B200 GPUs über eine ultraschnelle 900GB/s Chip-zu-Chip-Verbindung mit einer NVIDIA Grace CPU. Diese eng gekoppelte Konfiguration verspricht eine bis zu 30-fache Leistungssteigerung für LLM-Inferenz-Workloads im Vergleich zur bereits leistungsstarken H100 GPU, zusammen mit erheblichen Verbesserungen der Energieeffizienz.

Die NVIDIA Blackwell-Plattform markiert einen bedeutenden Fortschritt in der Computertechnologie und bietet beispiellose Effizienz, Leistung und Skalierbarkeit, die auf die anspruchsvollsten KI-Anwendungen zugeschnitten sind. Ihre Unterstützung durch führende Technologieunternehmen, ihre innovative Chiplet-Architektur, die auf fortschrittlicher Prozesstechnologie basiert, und ihr Potenzial, verschiedene Branchen zu revolutionieren, unterstreichen ihre Bedeutung für die fortlaufende Entwicklung des Rechnens und der künstlichen Intelligenz.