Die strategische Genialität der Natur: Warum kämpfen Hirsche nicht bis zum Tod?

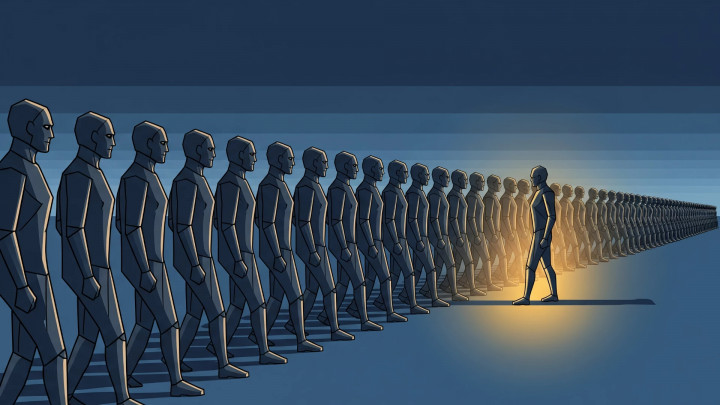

Im herbstlichen Wald stehen sich zwei gewaltige Rothirsche gegenüber. Sie verkeilen ihre Geweihe, demonstrieren ihre Stärke und röhren laut. Der Kampf ist spektakulär und brutal, doch in den meisten Fällen gibt das schwächere Tier schließlich auf und zieht sich zurück, sodass der Sieger die Gunst der Hirschkühe gewinnt. Nur selten enden diese Auseinandersetzungen tödlich. Aber warum? Das passt nicht zum klassischen Bild einer brutalen Natur, einem blutigen Kampf ums Überleben. Wenn das oberste Ziel die Weitergabe der eigenen Gene ist, warum versucht der Verlierer nicht, um jeden Preis zu gewinnen, selbst wenn er sein Leben riskiert?